Muốn trang tải nhanh, API mượt và chi phí hạ tầng giảm? Bài viết giúp bạn nắm Caching là gì, cách hoạt động và thời điểm áp dụng. Nội dung gồm cache hit miss, TTL, invalidation, thuật toán thay thế; các lớp cache từ trình duyệt, CDN proxy đến ứng dụng và database; 5 pattern đọc ghi phổ biến; so sánh Redis với Memcached; gợi ý triển khai Amazon ElastiCache; checklist chống thundering herd, theo dõi hit ratio, latency, quy ước key và lộ trình áp dụng.

Caching là gì?

Caching là một kỹ thuật lưu trữ tạm thời bản sao của dữ liệu được yêu cầu thường xuyên tại một vị trí gần hơn hoặc nhanh hơn nguồn dữ liệu gốc (ví dụ: database hoặc API). Mục đích cốt lõi của Caching là giúp truy cập dữ liệu nhanh hơn, qua đó tăng tốc độ phản hồi của ứng dụng hoặc website.

Hãy hình dung thế này: Nếu mỗi lần bạn cần thông tin về giá vàng (dữ liệu hiếm khi thay đổi), thay vì phải chạy đến ngân hàng (database) mỗi phút, bạn chỉ cần nhìn vào tờ báo sáng (cache) đặt ngay trên bàn. Việc này tiết kiệm đáng kể thời gian và công sức.

Cơ chế hoạt động: Dòng chảy dữ liệu qua cache

Để hiểu rõ hơn về cách Caching giúp tối ưu hiệu suất, chúng ta cần xem xét luồng dữ liệu khi một yêu cầu được gửi đến hệ thống có áp dụng bộ nhớ đệm.

Khi người dùng gửi một yêu cầu truy cập dữ liệu, ứng dụng sẽ không gọi thẳng đến nguồn gốc (database) mà chuyển hướng đến bộ nhớ cache trước. Quá trình này được gọi là “dòng chảy dữ liệu qua cache”.

Quy trình diễn ra như sau:

- Ứng dụng gửi yêu cầu: Ứng dụng hỏi cache xem dữ liệu đã tồn tại hay chưa.

- Kiểm tra cache: Hệ thống caching kiểm tra key (khóa) tương ứng với dữ liệu trong bộ nhớ.

- Phản hồi: Tùy thuộc vào kết quả kiểm tra, hệ thống sẽ có hai trường hợp chính: Cache Hit hoặc Cache Miss.

Hiểu rõ các thuật ngữ cơ bản này là chìa khóa để implement caching hiệu quả.

Cache hit, miss, warm-up, cold start

Trong cơ chế hoạt động của bộ nhớ đệm, có bốn trạng thái quan trọng mà mọi lập trình viên đều phải nắm vững:

- Cache Hit: Xảy ra khi dữ liệu được yêu cầu đã tồn tại trong bộ nhớ cache và vẫn còn hợp lệ (chưa hết hạn). Đây là kết quả lý tưởng, vì dữ liệu được trả về ngay lập tức với latency (độ trễ) cực thấp, tăng tốc độ phản hồi.

- Ví dụ: Một lập trình viên truy vấn giá sản phẩm A, và giá này đã có sẵn trong Redis cache.

- Cache Miss: Xảy ra khi dữ liệu được yêu cầu không tồn tại trong cache (có thể do chưa bao giờ được cache, đã bị xóa, hoặc đã hết hạn). Lúc này, ứng dụng buộc phải truy cập vào nguồn dữ liệu gốc (ví dụ: database), tốn thời gian hơn. Sau khi lấy được dữ liệu, ứng dụng sẽ ghi dữ liệu đó vào cache cho các lần truy cập sau.

- Cache Warm-up: Là quá trình chuẩn bị hoặc “làm ấm” cache bằng cách tải trước các dữ liệu quan trọng và thường xuyên truy cập vào bộ nhớ đệm trước khi hệ thống chính thức tiếp nhận lưu lượng truy cập lớn. Kỹ thuật này giúp tránh hiện tượng Cold Start và đảm bảo tỉ lệ Cache Hit cao ngay từ đầu.

- Cold Start: Xảy ra khi cache hoàn toàn trống rỗng (ví dụ: sau khi hệ thống caching khởi động lại hoặc mới triển khai). Mọi yêu cầu ban đầu đều dẫn đến Cache Miss, gây ra độ trễ cao và tạo áp lực lớn lên database cho đến khi cache được lấp đầy.

Để tối ưu hiệu suất, mục tiêu của chúng ta là tối đa hóa Cache Hit Ratio (Tỷ lệ Cache Hit) và giảm thiểu các trường hợp Cache Miss và Cold Start.

TTL, invalidation và chiến lược hết hạn

Dữ liệu trong cache không thể tồn tại mãi mãi vì nó có thể bị lỗi thời (stale data). Đây là lúc các khái niệm TTL và Cache Invalidation xuất hiện:

- TTL (Time To Live): Là thời gian tối đa mà một mục dữ liệu được coi là hợp lệ trong bộ nhớ đệm. Sau khi hết thời gian TTL, dữ liệu đó sẽ tự động bị đánh dấu là hết hạn và bị xóa khỏi cache ở lần truy cập tiếp theo (hoặc bị eviction).

- Việc thiết lập TTL cache cần sự cân bằng: TTL quá ngắn dẫn đến nhiều Cache Miss, TTL quá dài dẫn đến nguy cơ lệch dữ liệu (stale data).

- Cache Invalidation (Vô hiệu hóa Cache): Là hành động xóa hoặc đánh dấu dữ liệu trong cache là không hợp lệ một cách chủ động (thủ công hoặc tự động) ngay khi dữ liệu gốc (trong database) bị thay đổi.

- Chiến lược hết hạn (Expiration Strategy): Bên cạnh TTL dựa trên thời gian, các chiến lược phức tạp hơn (ví dụ: Cache Invalidation dựa trên sự kiện) được sử dụng để đảm bảo tính nhất quán dữ liệu cao hơn. Chẳng hạn, khi một bài viết được cập nhật, một tín hiệu sẽ được gửi đến cache (thường qua message queue) để xóa key của bài viết đó.

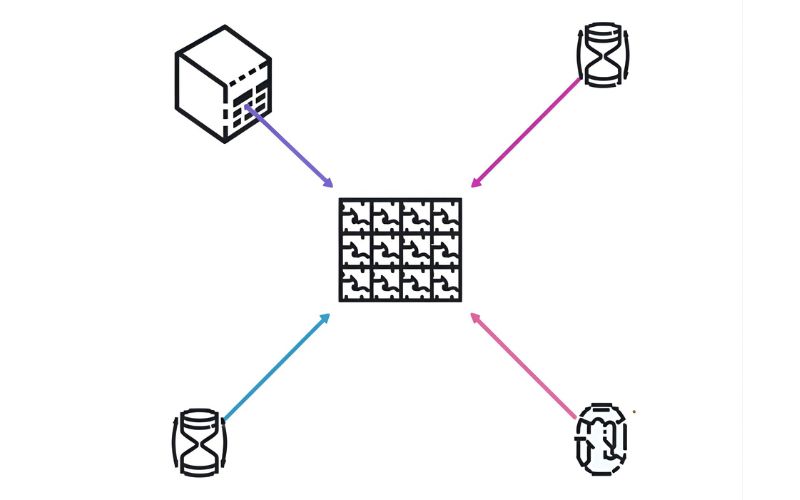

Thuật toán thay thế: LRU, LFU, FIFO

Khi bộ nhớ cache đầy (đặc biệt là in-memory cache), hệ thống cần một cơ chế để quyết định dữ liệu nào sẽ bị xóa (eviction) để nhường chỗ cho dữ liệu mới. Đây là lúc các thuật toán thay thế phát huy tác dụng:

- LRU (Least Recently Used): Đây là thuật toán phổ biến nhất. LRU giả định rằng dữ liệu được truy cập gần đây nhất có khả năng được truy cập lại cao hơn trong tương lai. Do đó, mục dữ liệu được truy cập ít gần đây nhất sẽ bị loại bỏ đầu tiên. Redis thường sử dụng biến thể của thuật toán LRU này.

- LFU (Least Frequently Used): LFU đếm số lần truy cập vào một mục dữ liệu. Mục dữ liệu được truy cập ít thường xuyên nhất sẽ bị loại bỏ đầu tiên. Thuật toán LFU phù hợp cho dữ liệu có tần suất truy cập không đồng đều.

- FIFO (First-In, First-Out): FIFO đơn giản là loại bỏ mục dữ liệu được thêm vào cache sớm nhất. Thuật toán này dễ thực hiện nhưng không tính đến tần suất sử dụng, có thể loại bỏ dữ liệu quan trọng nếu nó được thêm vào từ lâu.

Việc chọn đúng thuật toán giúp tối ưu bộ nhớ và duy trì Cache Hit Ratio ở mức cao nhất.

Bản đồ các lớp cache trong kiến trúc web

Hệ thống Caching trong một kiến trúc web hiện đại không chỉ là một hộp đơn lẻ, mà là một chuỗi các lớp (lớp cache) trải dài từ trình duyệt của người dùng đến database, tạo thành một kiến trúc caching phân tán. Mỗi lớp có vai trò và loại dữ liệu caching riêng biệt.

Cache phía trình duyệt (Client-side)

Đây là lớp cache gần người dùng nhất. Browser caching cho phép trình duyệt lưu trữ các tài nguyên tĩnh như file CSS, JavaScript, hình ảnh, và font chữ ngay trên thiết bị của người dùng.

- Cơ chế: Trình duyệt sử dụng HTTP Headers (như

Cache-Control,Expires,ETag,Last-Modified) để xác định xem có cần tải lại tài nguyên từ server hay không. - Lợi ích: Loại bỏ gần như hoàn toàn độ trễ mạng cho lần truy cập tiếp theo, giúp tốc độ tải trang đạt mức gần như tức thời.

- Keywords: Browser caching là gì, Cache-Control header, tăng tốc độ tải trang.

Cache mạng phân phối nội dung (CDN) và Internet caching

CDN (Content Delivery Network) là một mạng lưới máy chủ phân tán toàn cầu có nhiệm vụ lưu trữ bản sao của nội dung tĩnh và động, đặt chúng gần người dùng cuối (edge locations).

- Vai trò: Giảm khoảng cách địa lý giữa người dùng và server, giảm độ trễ mạng (latency) và bảo vệ server gốc (Origin Server) khỏi lưu lượng truy cập lớn.

- Ví dụ: Cloudflare cache là một dịch vụ CDN phổ biến, giúp website giảm tải server và chống lại các cuộc tấn công DDoS.

- Keywords: CDN là gì, Internet caching, Cloudflare cache.

Cache nội dung web tại edge và proxy

Proxy cache (còn gọi là Reverse Proxy Cache) nằm giữa người dùng và server ứng dụng của bạn. Nó lưu trữ các phản hồi HTTP (ví dụ: các trang HTML được tạo ra) và phục vụ chúng trực tiếp từ bộ nhớ của nó.

- Công cụ: Varnish cache là gì là một ví dụ điển hình cho Proxy Cache. Nó có khả năng xử lý hàng ngàn yêu cầu mỗi giây, giảm đáng kể gánh nặng cho server backend.

- Lợi ích: Tối ưu hóa việc phân phát nội dung động (Dynamic content) đã được render (kết xuất) sẵn, nâng cao hiệu năng ứng dụng.

- Keywords: Proxy cache, Varnish cache là gì.

Cache tầng ứng dụng: in-memory, distributed cache

Đây là lớp caching do chính ứng dụng web của bạn quản lý.

- In-memory cache: Bộ nhớ đệm được lưu trữ trực tiếp trong bộ nhớ (RAM) của server ứng dụng. Nhanh nhưng không thể chia sẻ giữa nhiều server.

- Distributed cache: Hệ thống caching phân tán, sử dụng các công cụ chuyên biệt như Redis hoặc Memcached. Dữ liệu được chia sẻ và có thể mở rộng mở rộng ngang (scale horizontally) trên nhiều máy chủ, rất phù hợp cho các ứng dụng có lưu lượng truy cập cao.

- Keywords: Distributed cache, In-memory cache, Caching tầng ứng dụng.

Cache cơ sở dữ liệu và truy vấn

Lớp cuối cùng, giúp giảm tải cho database server. Thay vì thực hiện lại một truy vấn phức tạp (ví dụ: JOIN nhiều bảng) mỗi lần được gọi, kết quả của truy vấn đó sẽ được lưu vào cache.

- Ứng dụng: Query result caching, Giảm tải database. Đặc biệt hữu ích cho các báo cáo hoặc dữ liệu thống kê hiếm khi thay đổi.

- Keywords: Cache database, Query result caching, Giảm tải database.

Bộ nhớ và công cụ thực thi của Caching

Để implement caching thực chiến, bạn cần lựa chọn đúng công cụ. Lựa chọn giữa các công cụ caching như Redis và Memcached phụ thuộc vào loại dữ liệu và yêu cầu về tính năng của ứng dụng.

RAM, in-memory engines và đặc tính hiệu năng

Caching hiệu quả nhất khi được lưu trữ trong RAM (Random Access Memory). So với ổ đĩa SSD, việc truy cập RAM nhanh hơn khoảng 1000 lần.

- In-memory engine: Là các hệ thống quản lý dữ liệu được thiết kế để hoạt động chủ yếu trong RAM, mang lại đặc tính hiệu năng cực cao (độ trễ dưới 1ms). Cả Redis và Memcached đều là in-memory engine.

- Lợi ích: Độ trễ thấp (low latency) giúp tăng tốc độ phản hồi ứng dụng.

- Keywords: RAM và caching, In-memory engine.

So sánh nhanh Redis và Memcached

Cả hai đều là công cụ caching phổ biến, nhưng có sự khác biệt quan trọng:

| Tính năng | Redis | Memcached |

|---|---|---|

| Kiểu dữ liệu | Hỗ trợ đa dạng (Strings, Lists, Hashes, Sets, Sorted Sets) | Chỉ hỗ trợ cơ bản (Strings) |

| Tính bền vững | Có khả năng Persistence (lưu dữ liệu xuống đĩa) | Không có Persistence (chỉ In-memory) |

| Tính năng | Transactions, Pub/Sub, Lua Scripting | Đơn giản, tốc độ cao (vì ít tính năng) |

| Trường hợp dùng | Cache Session, Leaderboard, Message Queue, Real-time data | Cache Object đơn giản, dữ liệu không yêu cầu Persistence |

Fast Byte khuyến nghị sử dụng Redis trong hầu hết các trường hợp hiện đại vì tính năng phong phú và khả năng lưu trữ cấu trúc dữ liệu phức tạp. Memcached phù hợp cho việc cache object thuần túy và cần tốc độ tuyệt đối.

Mẫu dùng phổ biến theo khối lượng và kiểu dữ liệu

Lựa chọn mẫu sử dụng Redis hay Memcached tùy thuộc vào nhu cầu:

- Cache Session (Redis): Dùng Hash hoặc String để lưu trữ thông tin phiên người dùng, cần Redis vì tính bền vững (Persistence) nhẹ và kiểu dữ liệu linh hoạt.

- Cache Product Detail (Memcached/Redis): Lưu trữ thông tin chi tiết sản phẩm. Nếu chỉ là JSON/String đơn giản, Memcached có thể nhanh hơn. Nếu cần cấu trúc phức tạp (ví dụ: lưu trữ danh sách các bình luận liên quan), Redis là lựa chọn tốt hơn.

- Cache Leaderboard (Redis Sorted Sets): Redis với kiểu dữ liệu Sorted Sets là công cụ tuyệt vời để xây dựng bảng xếp hạng theo thời gian thực (real-time).

Chiến lược đọc/ghi với cache (các pattern thực chiến)

Tại Fast Byte, việc cấu hình caching không chỉ dừng lại ở cài đặt Redis mà còn nằm ở cách ứng dụng tổ chức luồng đọc–ghi giữa cache và cơ sở dữ liệu. Có năm chiến lược caching chủ đạo mà chúng tôi khuyến nghị áp dụng linh hoạt theo bối cảnh hệ thống.

Cache-Aside (Lazy Loading)

Cache-Aside là gì? Đây là mô hình phổ biến nhất, trong đó ứng dụng (bên ngoài) chịu trách nhiệm quản lý cả logic đọc/ghi vào cache và database.

- Đọc (Read): Ứng dụng kiểm tra cache trước. Nếu Cache Miss, ứng dụng lấy dữ liệu từ database, sau đó ghi dữ liệu đó vào cache trước khi trả về cho người dùng (Lazy Loading cache).

- Ghi (Write): Ứng dụng ghi thẳng vào database, sau đó xóa key tương ứng khỏi cache (Cache Invalidation).

- Ưu điểm: Dễ triển khai, chỉ cache những dữ liệu thực sự cần (Lazy Loading).

- Nhược điểm: Tăng độ trễ cho lần truy cập đầu tiên (Cache Miss).

Read-Through

Trong Read-Through cache pattern, logic đọc được chuyển giao cho cache system (ví dụ: một lớp abstraction). Nếu Cache Miss, cache tự động gọi database, lấy dữ liệu, lưu trữ nó và trả về cho ứng dụng.

- Ưu điểm: Ứng dụng đơn giản hơn, không cần biết logic lấy dữ liệu từ database.

- Nhược điểm: Phức tạp hơn để implement (cần một Cache Provider).

Write-Through

Với Write-Through cache pattern, mỗi khi ứng dụng cần ghi dữ liệu, nó sẽ ghi đồng thời vào cả cache và database.

- Ưu điểm: Dữ liệu trong cache và database luôn nhất quán. Dữ liệu mới luôn có sẵn (giảm Cache Miss sau khi ghi).

- Nhược điểm: Thêm độ trễ cho thao tác ghi (phải ghi vào hai nơi).

Write-Around

Write-Around cache pattern là một biến thể của Write-Through, trong đó dữ liệu mới được ghi thẳng vào database và bỏ qua cache hoàn toàn.

- Ứng dụng: Thường dùng cho dữ liệu lớn, ít thường xuyên truy cập (ví dụ: log file, archive). Dữ liệu chỉ được nạp vào cache sau lần đọc đầu tiên (Cache-Aside).

- Ưu điểm: Không làm tắc nghẽn cache với dữ liệu không cần thiết.

Write-Back (Write-Behind)

Write-Back cache pattern (hoặc Write-Behind cache) là chiến lược nhanh nhất cho thao tác ghi: dữ liệu chỉ được ghi vào cache trước, và việc ghi vào database sẽ được thực hiện bất đồng bộ (Async) sau đó.

- Ưu điểm: Độ trễ ghi cực thấp, giúp tăng tốc độ phản hồi của ứng dụng ngay lập tức.

- Nhược điểm: Rủi ro mất dữ liệu nếu cache server bị lỗi trước khi kịp ghi vào database (cần cơ chế Persistence và Recovery phức tạp).

Thiết kế và mẫu áp dụng Caching trong ứng dụng

Caching không chỉ dành cho dữ liệu thô. Các lập trình viên thường áp dụng caching vào nhiều cấp độ khác nhau để tối ưu ứng dụng toàn diện.

Object caching, partial page caching, fragment caching

- Object caching: Lưu trữ các đối tượng dữ liệu phức tạp (ví dụ: một đối tượng User, một mảng bài viết) sau khi chúng được xây dựng.

- Partial page caching: Lưu trữ một phần của trang web được render sẵn (ví dụ: header, footer, sidebar).

- Fragment caching: Lưu trữ các khối nội dung nhỏ nhất (ví dụ: một component React/Angular, một widget) để tái sử dụng.

- Keywords: Object caching, Fragment caching, Tối ưu ứng dụng bằng cache.

Query result caching, computed value caching

- Query result caching: Cache kết quả của các truy vấn database tốn kém.

- Computed value caching: Lưu trữ kết quả của các phép tính toán phức tạp hoặc các hàm mất thời gian (ví dụ: tính thuế, phân tích dữ liệu lớn) để tránh tính toán lại.

Session, token và rate-limit caching

- Session Caching: Sử dụng cache (thường là Redis) để lưu trữ dữ liệu phiên người dùng, giúp mở rộng ứng dụng dễ dàng.

- Token Caching: Lưu trữ các token (ví dụ: JWT, OAuth) để kiểm tra tính hợp lệ nhanh hơn so với việc truy cập database.

- Rate-limit caching: Sử dụng các lệnh Atomic (ví dụ:

INCRcủa Redis) để đếm và kiểm soát số lượng yêu cầu (request) mà một người dùng/IP có thể thực hiện trong một khoảng thời gian, bảo vệ API của bạn.

Cách triển khai Caching thành công

Triển khai Caching thành công đòi hỏi nhiều hơn là chỉ cài đặt Redis. Đội ngũ Fast Byte đúc kết các nguyên tắc quan trọng sau để đạt hiệu quả cao nhất:

Chọn đúng dữ liệu để cache và đặt TTL hợp lý

- Dữ liệu nên cache: Dữ liệu được đọc thường xuyên nhưng hiếm khi được ghi (ví dụ: danh mục sản phẩm, cấu hình website, bài viết cũ).

- Dữ liệu không nên cache: Dữ liệu thay đổi liên tục (ví dụ: số dư tài khoản ngân hàng) hoặc dữ liệu nhạy cảm, cá nhân (trừ khi có biện pháp bảo mật nghiêm ngặt).

- Đặt TTL: Dữ liệu ít thay đổi có thể đặt TTL dài (1 giờ – 24 giờ). Dữ liệu động hơn nên đặt TTL ngắn (5 phút – 30 phút).

Chiến lược làm ấm cache và kiểm soát bùng nổ truy cập (thundering herd)

- Cache Warm-up: Sau khi triển khai hoặc khởi động lại, hãy chạy một script để tải trước dữ liệu quan trọng (ví dụ: 100 sản phẩm hot nhất) vào cache để tránh Cold Start.

- Kiểm soát Thundering Herd: Hiện tượng Thundering Herd xảy ra khi hàng nghìn request cùng lúc dẫn đến Cache Miss và cùng đổ về database. Khắc phục bằng cách sử dụng Locking Mechanism (chỉ cho phép một request duy nhất gọi database, các request khác chờ kết quả từ cache) hoặc sử dụng TTL Jitter (thêm ngẫu nhiên vài giây vào TTL để các mục không hết hạn cùng lúc).

- Keywords: Thundering herd problem, cache warm-up.

Giám sát hit ratio, latency, memory footprint

Giám sát là yếu tố then chốt để tối ưu cache:

- Cache Hit Ratio: Tỷ lệ số lần Cache Hit trên tổng số yêu cầu. Tỷ lệ lý tưởng thường là 90% trở lên. Tỷ lệ thấp cho thấy bạn cần điều chỉnh TTL hoặc thuật toán thay thế.

- Latency (Độ trễ): Thời gian phản hồi của cache (thường dưới 1ms). Độ trễ tăng cao có thể báo hiệu vấn đề về mạng hoặc bộ nhớ đệm bị quá tải.

- Memory Footprint: Lượng bộ nhớ mà cache đang sử dụng. Cần giám sát để tránh tình trạng Cache bị Paging (đẩy dữ liệu ra ổ đĩa) khi hết RAM.

Quy ước key, phân vùng và mở rộng ngang

- Quy ước key: Thiết lập một quy tắc thống nhất cho Cache Key (ví dụ:

[EntityName]:[Id]:[Field]). Key hiệu quả giúp việc tìm kiếm và vô hiệu hóa cache dễ dàng. - Phân vùng (Partitioning/Sharding): Chia bộ nhớ đệm thành nhiều cụm (cluster) để lưu trữ dữ liệu lớn hơn mức chứa của một server.

- Mở rộng ngang (Horizontal Scaling): Bổ sung thêm các cache server (node) khi lưu lượng truy cập tăng, đảm bảo khả năng mở rộng tuyến đầu của hệ thống.

Tính nhất quán và độ tin cậy của Caching

Thách thức lớn nhất của Caching là duy trì tính nhất quán dữ liệu trong khi vẫn giữ được tốc độ.

Mức nhất quán: eventual vs strong trong bối cảnh cache

- Strong Consistency (Nhất quán mạnh): Dữ liệu được đọc luôn là dữ liệu mới nhất. Rất khó đạt được với cache phân tán vì phải đảm bảo cache và database được ghi cùng lúc.

- Eventual Consistency (Nhất quán cuối cùng): Dữ liệu có thể bị lệch dữ liệu (stale data) trong một khoảng thời gian ngắn (chủ yếu là TTL), nhưng cuối cùng sẽ trở nên nhất quán. Đây là mô hình phổ biến nhất trong caching để đổi lấy hiệu suất cao.

- Keywords: Tính nhất quán dữ liệu cache, Cache consistency.

Xử lý mất cache, lỗi nút và phục hồi

- Mất cache: Nếu cache server bị lỗi hoặc khởi động lại, toàn bộ dữ liệu cache sẽ biến mất. Điều này gây ra một đợt Cache Miss khổng lồ và áp lực lớn lên database.

- Phục hồi (Recovery): Cần cơ chế Persistence (ví dụ: AOF/RDB của Redis) để cache có thể tự phục hồi dữ liệu sau lỗi. Đồng thời, áp dụng Thundering Herd protection để ngăn chặn database bị quá tải trong quá trình phục hồi.

An toàn dữ liệu, cô lập và bảo mật khi cache

- Bảo mật: Dữ liệu nhạy cảm (mã hóa, token) cần được mã hóa khi lưu vào cache. Các kết nối đến cache server (ví dụ: Redis) nên được bảo vệ bằng SSL/TLS và đặt trong mạng nội bộ (private network).

- Cô lập (Isolation): Phân chia cache server theo môi trường (Development, Staging, Production) và theo loại dữ liệu (ví dụ: cache session riêng biệt) để tránh sự cố lan truyền.

Lợi ích định lượng Caching và tác động hệ thống

Việc áp dụng Caching mang lại những lợi ích rõ ràng, có thể đo lường được bằng các chỉ số KPI:

Tăng tốc độ phản hồi và trải nghiệm người dùng

Theo thống kê của Google, chỉ cần độ trễ tăng thêm 1 giây, tỷ lệ bỏ trang (bounce rate) có thể tăng tới 20%. Caching trực tiếp giảm độ trễ, giúp tăng tốc độ phản hồi từ vài trăm mili giây xuống dưới 10ms.

Giảm tải backend, nâng IOPS đọc và tiết kiệm chi phí

- Giảm tải: Một hệ thống caching hiệu quả có thể hấp thụ 95% lưu lượng đọc, giúp server backend chỉ cần xử lý 5% yêu cầu.

- Nâng IOPS: Cache in-memory có thể đạt hàng triệu IOPS (Input/Output Operations Per Second), cao hơn gấp nhiều lần so với database.

- Tiết kiệm chi phí: Bằng cách giảm tải, bạn có thể chạy ứng dụng trên các instance (máy chủ ảo) nhỏ hơn, tiết kiệm chi phí server đáng kể.

Hấp thụ spike lưu lượng và mở rộng tuyến đầu

Trong các sự kiện lớn (Flash Sales, ra mắt sản phẩm), lưu lượng truy cập có thể tăng vọt đột ngột. Caching hoạt động như một “vành đai phòng thủ”, hấp thụ spike lưu lượng này, giữ cho database không bị sập và đảm bảo tính ổn định.

Mặt trái của Caching và cách khắc phục

Dù mạnh mẽ, Caching không phải là giải pháp không có rủi ro.

Lệch dữ liệu và rủi ro stale data

Đây là rủi ro của caching lớn nhất. Lệch dữ liệu (stale data) xảy ra khi dữ liệu trong cache không còn khớp với dữ liệu trong nguồn gốc.

- Khắc phục: Sử dụng cơ chế Cache Invalidation dựa trên sự kiện thay vì chỉ dựa vào TTL (ví dụ: dùng Message Queue để thông báo thay đổi).

Chi phí vận hành, quan sát và kiểm thử

Caching thêm một tầng phức tạp vào kiến trúc. Việc quản lý, giám sát (hit ratio, latency) và kiểm thử các kịch bản lỗi (ví dụ: kiểm thử tình trạng Cache Miss toàn bộ) đòi hỏi công sức và công cụ chuyên môn.

Tối ưu bộ nhớ, phân mảnh và kích thước đối tượng

- Phân mảnh (Fragmentation): Trong các hệ thống như Redis, việc tạo/xóa key liên tục có thể dẫn đến phân mảnh bộ nhớ, làm giảm hiệu quả sử dụng RAM.

- Kích thước đối tượng: Cache không nên lưu trữ các đối tượng quá lớn. Đối tượng lớn làm tăng độ trễ khi đọc/ghi và tiêu tốn nhiều bộ nhớ đệm.

Caching trên nền tảng đám mây

Các nền tảng đám mây (Cloud) cung cấp các dịch vụ Caching được quản lý (Managed Service), giúp bạn không cần lo lắng về việc vận hành và bảo trì.

Tổng quan Amazon ElastiCache

Amazon ElastiCache là dịch vụ caching được quản lý của AWS, hỗ trợ cả hai công cụ là Redis và Memcached.

- Lợi ích: Tự động mở rộng ngang, tự động thay thế nút (Node Replacement), vá lỗi và giám sát tích hợp.

Khi nào chọn Redis, khi nào chọn Memcached trên ElastiCache

- Chọn Redis: Khi cần tính bền vững, kiểu dữ liệu phức tạp (Sets, Hashes), khả năng Pub/Sub, hoặc cần cache session.

- Chọn Memcached: Khi bạn cần một bộ cache object đơn giản, tốc độ cực cao, và có thể chấp nhận dữ liệu bị mất khi khởi động lại.

Triển khai, cấu hình, bảo mật và cost-saving tips

Fast Byte khuyến nghị:

- Triển khai: Luôn đặt ElastiCache trong mạng riêng (VPC) để bảo mật.

- Cấu hình: Sử dụng chế độ Cluster để mở rộng ngang.

- Cost-Saving Tips: Sử dụng Reserved Nodes cho các nhu cầu dài hạn để tiết kiệm chi phí so với On-Demand Nodes.

Lộ trình áp dụng theo từng bước

Đây là lộ trình áp dụng caching mà Fast Byte khuyến nghị để tối ưu hiệu suất hệ thống của bạn:

Xác định điểm nghẽn và chọn lớp cache ưu tiên

- Sử dụng công cụ giám sát (ví dụ: Google Analytics, New Relic) để xác định điểm nghẽn (ví dụ: truy vấn database chậm nhất, trang tải lâu nhất).

- Chọn lớp cache ưu tiên: Bắt đầu từ lớp đơn giản nhất (ví dụ: Browser Caching và CDN) rồi tiến đến Cache tầng ứng dụng (Redis/Memcached) và cuối cùng là Cache database.

Chạy thử, đo lường, tối ưu và mở rộng

- Chạy thử: Implement caching trên môi trường Staging.

- Đo lường: Theo dõi Cache Hit Ratio, độ trễ trung bình của API/trang.

- Tối ưu: Điều chỉnh TTL, thuật toán thay thế dựa trên số liệu thực tế.

- Mở rộng: Thêm nút cache (Sharding/Clustering) khi lưu lượng tăng.

Tài liệu hóa và vận hành lâu dài

Ghi lại tài liệu hóa các chiến lược caching, quy ước key, và quy trình phục hồi sau lỗi. Đảm bảo đội ngũ vận hành hiểu rõ cơ chế Cache Invalidation để tránh lệch dữ liệu.

Nếu website của bạn đang chậm, hãy bắt đầu bằng việc cài đặt một plugin caching (đối với WordPress) hoặc triển khai dịch vụ CDN như Cloudflare. Đó là bước nhỏ tiếp theo đơn giản nhất để cải thiện hiệu năng ngay lập tức. Sau đó, hãy nghiên cứu Redis và các chiến lược Cache-Aside để nâng cấp ứng dụng của bạn lên một tầm cao mới.

Bạn cần trợ giúp gì thêm về việc tối ưu caching hay muốn Fast Byte đi sâu vào một chiến lược caching cụ thể không?