Latency là thời gian để dữ liệu di chuyển từ thiết bị đến máy chủ và quay lại. Độ trễ cao ảnh hưởng đến game online, gọi video và hiệu suất công việc. Cùng tìm hiểu Latency là gì, nguyên nhân gây nên độ trễ mạng, cách đo Latency và các phương pháp tối ưu hóa Latency để nâng cao trải nghiệm người dùng và hiệu suất mạng.

Latency là gì?

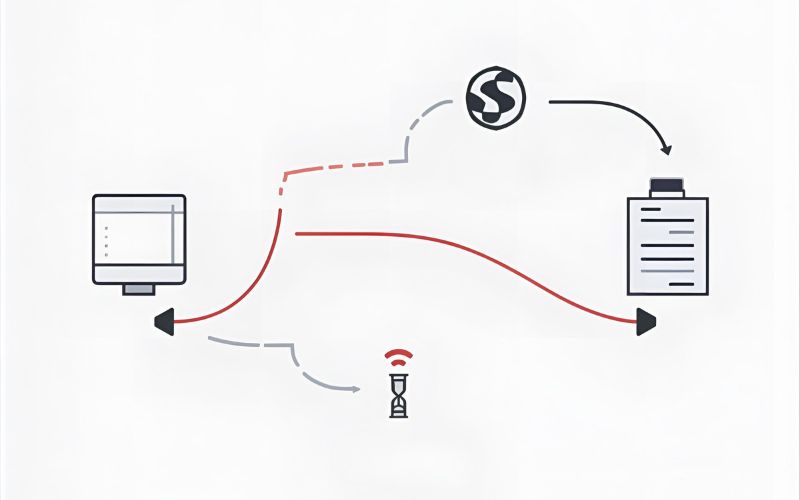

Latency (hay độ trễ) là thuật ngữ kỹ thuật chỉ khoảng thời gian cần thiết để một gói dữ liệu (data packet) di chuyển từ điểm gốc (thiết bị của bạn) đến điểm đích (máy chủ) và quay trở lại. Về cơ bản, Latency chính là độ trễ mà người dùng cảm nhận được khi tương tác với mạng Internet.

Ví dụ, khi bạn nhấp chuột để mở một trang web, dữ liệu yêu cầu phải đi từ máy tính của bạn đến máy chủ của trang web đó (ví dụ: máy chủ của Google hoặc Facebook) và sau đó dữ liệu của trang web phải quay ngược lại máy tính của bạn. Khoảng thời gian toàn bộ quá trình đi và về này diễn ra chính là độ trễ Latency.

Phân biệt Latency và Tốc độ Mạng

Nhiều người dùng nhầm lẫn giữa Latency và tốc độ tải xuống/tải lên (Bandwidth). Để dễ hình dung, hãy tưởng tượng mạng Internet là một đường cao tốc:

- Bandwidth (Băng thông): Chiều rộng của đường cao tốc, quyết định số lượng ô tô (dữ liệu) có thể di chuyển qua cùng một lúc. Băng thông càng cao, bạn có thể tải nhiều dữ liệu hơn (tốc độ tải nhanh hơn).

- Latency (Độ trễ): Khoảng thời gian ô tô (gói dữ liệu) cần để di chuyển từ điểm A đến điểm B. Latency thấp nghĩa là thời gian phản hồi (phản ứng) nhanh.

Một kết nối mạng lý tưởng phải có cả Bandwidth cao (tải được nhiều) và Latency thấp (phản hồi nhanh).

Đơn vị đo Latency

Độ trễ Latency luôn được đo bằng mili giây (ms).

- 1 giây = 1000 mili giây (ms).

- Mức Latency lý tưởng cho hầu hết các tác vụ thời gian thực (như chơi game) là dưới 50ms.

- Khi Latency vượt quá 100ms, người dùng sẽ bắt đầu cảm nhận rõ rệt sự chậm trễ (lag).

Vì sao Latency quan trọng trong công nghệ hiện đại?

Trong kỷ nguyên số, nơi mọi tương tác đều diễn ra tức thời, Latency thấp đã trở thành một yêu cầu cơ bản, đặc biệt trong các lĩnh vực cần sự phản hồi gần như ngay lập tức. Việc kiểm soát độ trễ Latency không chỉ là vấn đề về tốc độ mà còn là vấn đề về độ tin cậy và trải nghiệm người dùng.

Trải nghiệm người dùng và tính tương tác

Latency cao trực tiếp phá vỡ tính tương tác.

- Game Online: Một game thủ cần phản ứng trong 100ms. Nếu Latency là 80ms, thời gian phản ứng thực tế của họ là 180ms. Trong các game bắn súng (FPS) hoặc MOBA, 80ms độ trễ mạng có thể là sự khác biệt giữa thắng và bại.

- Họp Trực tuyến/Gọi Video: Khi Latency lớn, tiếng nói và hình ảnh sẽ bị lệch, dẫn đến sự khó chịu và gián đoạn giao tiếp. Mọi người dùng đều mong muốn một cuộc họp không có độ trễ Latency để trao đổi hiệu quả.

Hiệu suất kinh doanh và tài chính

Độ trễ Latency có tác động nghiêm trọng đến hiệu suất kinh doanh, đặc biệt trong các ngành công nghiệp đòi hỏi tốc độ xử lý dữ liệu cực cao.

- Giao dịch Tài chính (High-Frequency Trading): Trong lĩnh vực này, lợi nhuận có thể được tính bằng ms. Giảm Latency xuống 1ms có thể mang lại lợi thế cạnh tranh khổng lồ.

- Thương mại điện tử: Nghiên cứu chỉ ra rằng, nếu một trang web thương mại điện tử bị tăng Latency thêm 100ms, tỷ lệ chuyển đổi có thể giảm tới 7%. Người dùng không kiên nhẫn chờ đợi một trang web phản hồi chậm.

Vì vậy, việc tối ưu độ trễ Latency là ưu tiên hàng đầu của mọi doanh nghiệp và nhà cung cấp dịch vụ như Fast Byte.

Các nguyên nhân chính gây ra độ trễ Latency

Hiểu được tại sao latency cao là bước đầu tiên để tìm ra giải pháp tối ưu. Độ trễ mạng sinh ra từ nhiều khâu trong quá trình truyền dữ liệu, bao gồm cả khoảng cách vật lý và chất lượng thiết bị.

Khoảng cách vật lý (Distance and Geography)

Đây là nguyên nhân cơ bản nhất. Dữ liệu di chuyển dưới dạng ánh sáng trong cáp quang, nhưng tốc độ ánh sáng là hữu hạn.

- Lý thuyết: Gói dữ liệu gửi từ Hà Nội đến một máy chủ tại Singapore (khoảng 2.500 km) phải mất một thời gian nhất định (thường khoảng 30-40ms). Đây là độ trễ Latency tối thiểu không thể loại bỏ.

- Thực tế: Các gói dữ liệu không di chuyển theo đường thẳng. Chúng đi qua các bộ định tuyến, cáp ngầm, và trạm trung chuyển, làm tăng thêm thời gian trễ. Việc tìm kiếm máy chủ gần nhất là giải pháp trực tiếp để giảm loại Latency này.

Thiết bị phần cứng và cấu hình mạng nội bộ

Chất lượng và cấu hình của các thiết bị tại nhà hoặc văn phòng cũng là nguồn gốc gây ra độ trễ Latency đáng kể.

- Router và Modem: Các thiết bị cũ, kém chất lượng hoặc quá tải (nhiều thiết bị kết nối cùng lúc) không thể xử lý gói dữ liệu đủ nhanh, dẫn đến tăng Latency.

- Cáp mạng: Cáp Ethernet bị hỏng, cũ hoặc sử dụng loại cáp không đạt chuẩn có thể gây ra hiện tượng Packet Loss (mất gói dữ liệu), buộc hệ thống phải gửi lại gói tin, làm tăng độ trễ mạng.

Tắc nghẽn mạng (Network Congestion)

Tắc nghẽn xảy ra khi lượng dữ liệu được gửi đi vượt quá khả năng xử lý của mạng hoặc máy chủ.

- Internet Service Provider (ISP) Congestion: Khi tất cả hàng xóm của bạn sử dụng mạng cùng một lúc (giờ cao điểm), băng thông có thể bị phân chia quá mức, khiến bộ định tuyến của ISP bị quá tải, gây tăng đột biến Latency.

- Overloaded Servers: Nếu máy chủ mà bạn đang kết nối (ví dụ: máy chủ game) có quá nhiều người truy cập hoặc đang xử lý các tác vụ nặng, nó sẽ phản hồi chậm, làm tăng độ trễ Latency đo được.

Lỗi định tuyến và Protocol (TCP/IP)

Quy trình định tuyến gói dữ liệu cũng góp phần tạo nên Latency.

- Định tuyến không hiệu quả: Các gói dữ liệu có thể bị gửi qua các tuyến đường vòng, không phải là tuyến đường ngắn nhất. Mỗi lần đi qua một bộ định tuyến mới, đều làm tăng thêm một chút Latency vào tổng thời gian trễ.

- Giao thức TCP/IP: Giao thức TCP/IP (Transmission Control Protocol/Internet Protocol) có cơ chế kiểm tra lỗi và đảm bảo gói tin được gửi đến. Nếu xảy ra Packet Loss, giao thức này sẽ yêu cầu gửi lại, làm Latency tăng gấp nhiều lần.

Cách đo và tính độ trễ Latency chuẩn xác

Việc cách đo Latency một cách chính xác giúp bạn xác định được vấn đề nằm ở đâu: mạng nội bộ, ISP, hay máy chủ đích.

Sử dụng công cụ Ping

Công cụ Ping là cách phổ biến và trực tiếp nhất để đo Latency. Ping (Packet Internet Groper) gửi một gói tin ICMP (Internet Control Message Protocol) đến máy chủ đích và đo thời gian cần thiết để nhận được phản hồi.

- Thao tác: Trên máy tính, mở Command Prompt (Windows) hoặc Terminal (macOS/Linux).

- Lệnh cơ bản:

ping [địa chỉ IP hoặc domain](Ví dụ:ping google.com). - Kết quả: Kết quả trả về sẽ hiển thị thời gian tính bằng ms cho mỗi gói tin. Đây chính là độ trễ Latency (Round Trip Time – RTT) từ thiết bị của bạn đến máy chủ đích.

Chỉ số Round Trip Time (RTT)

Latency thường được tính bằng Round Trip Time (RTT). RTT là tổng thời gian bao gồm:

RTT=(Thời gian truyền yêu cầu)+(Thời gian xử lý yêu cầu tại Server)+(Thời gian truyền phản hồi)

- Khi bạn sử dụng lệnh Ping, con số ms nhận được chính là RTT. RTT phản ánh độ trễ toàn diện mà người dùng cảm nhận được.

Công cụ đo Latency trực tuyến và chuyên nghiệp

Ngoài Ping, bạn có thể sử dụng các công cụ đo latency trực tuyến để có cái nhìn trực quan hơn:

- Speedtest: Hầu hết các trang kiểm tra tốc độ nổi tiếng đều hiển thị chỉ số Ping (tức Latency) bên cạnh tốc độ tải lên và tải xuống.

- Công cụ APM (Application Performance Monitoring): Các kỹ sư sử dụng công cụ chuyên dụng để theo dõi độ trễ Latency của từng thành phần trong hệ thống, giúp xác định chính xác nút thắt cổ chai.

Tác động của Latency đến trải nghiệm người dùng và hiệu suất

Độ trễ Latency cao không chỉ gây khó chịu; nó còn ảnh hưởng trực tiếp đến hiệu suất công việc và sự cạnh tranh.

Game online và Ping cao

Đây là nơi độ trễ mạng bộc lộ rõ ràng nhất.

- Game FPS (First-Person Shooter): Latency trên 50ms là bất lợi lớn. Latency trên 100ms khiến hành động của bạn luôn trễ hơn đối thủ. Khi Ping cao, game thủ sẽ thấy nhân vật giật cục hoặc bị dịch chuyển ngược lại (rubber-banding), do gói dữ liệu bị gửi và nhận không đồng bộ.

- Độ trễ Latency quá mức sẽ kích hoạt cơ chế bù trễ của game, nhưng thường không thể khắc phục hoàn toàn sự thiếu đồng bộ.

Tốc độ tải website và SEO

Ảnh hưởng của latency đến tốc độ website là một yếu tố SEO quan trọng.

- Core Web Vitals: Google sử dụng các chỉ số trải nghiệm người dùng, bao gồm cả tốc độ tải trang (mà Latency là một thành phần cơ bản). Latency càng thấp, thời gian phản hồi máy chủ càng nhanh, giúp cải thiện điểm số Google PageSpeed Insights.

- Tỷ lệ thoát: Người dùng hiện đại có xu hướng thoát khỏi trang web nếu trang tải quá 3 giây. Latency cao trực tiếp làm tăng thời gian tải trang, dẫn đến tỷ lệ thoát cao và giảm khả năng chuyển đổi.

Các phương pháp phổ biến để giảm thiểu Latency

Nếu bạn đang tìm cách giảm latency hiệu quả, đặc biệt là giảm độ trễ mạng khi chơi game online hoặc làm việc, dưới đây là các chiến lược từ cơ bản đến nâng cao mà Fast Byte khuyến nghị.

Tối ưu hóa mạng nội bộ và thiết bị (Nhóm giải pháp tại nhà)

Đây là những bước đơn giản nhưng mang lại hiệu quả tức thì, giải quyết các nguyên nhân phần cứng đã nêu.

- Sử dụng kết nối dây (Ethernet): Kết nối Wi-Fi luôn có độ trễ Latency cao hơn và không ổn định bằng cáp mạng Ethernet do nhiễu sóng. Chuyển sang dùng dây cáp là ưu tiên hàng đầu để giảm Latency cho PC/Console.

- Khởi động lại Router/Modem: Thiết bị hoạt động liên tục có thể bị quá tải bộ nhớ đệm, dẫn đến tăng độ trễ mạng. Khởi động lại giúp làm sạch bộ đệm và thiết lập lại kết nối.

- Cập nhật Firmware: Các bản cập nhật firmware thường vá lỗi và tối ưu hóa hiệu suất xử lý gói dữ liệu của router, giúp giảm Latency không cần thiết.

Sử dụng Mạng riêng Ảo cho Game (GPN/VPN)

Đối với game thủ, các dịch vụ Mạng riêng Ảo cho Game (Gaming Private Network – GPN) hoặc VPN có thể giúp giảm độ trễ Latency một cách đáng ngạc nhiên, ngay cả khi chúng ta nghĩ VPN làm tăng trễ.

- Nguyên tắc hoạt động: Các dịch vụ này thiết lập một “đường hầm” trực tiếp, được tối ưu hóa. Thay vì để gói dữ liệu đi qua các bộ định tuyến vòng vèo, GPN/VPN cho phép gói dữ liệu của bạn đi qua máy chủ của họ, sử dụng tuyến đường đã được tinh chỉnh để có Latency thấp nhất có thể đến máy chủ game đích.

- Kết quả: Mặc dù GPN/VPN thêm một điểm dừng, nhưng nó thường loại bỏ các điểm nghẽn và định tuyến kém hiệu quả của ISP, dẫn đến Latency ổn định và thấp hơn.

Áp dụng Công nghệ CDN (Content Delivery Network)

Đối với các nhà phát triển website, sử dụng CDN là giải pháp tối ưu độ trễ Latency cho người dùng toàn cầu.

- Cách thức: CDN lưu trữ bản sao nội dung tĩnh (hình ảnh, CSS, JavaScript) của website trên các máy chủ đặt tại nhiều khu vực địa lý khác nhau (Thực thể: AWS, Google Cloud, Akamai).

- Lợi ích: Khi người dùng ở Việt Nam truy cập website, họ sẽ tải nội dung từ máy chủ CDN gần nhất (ví dụ: máy chủ CDN ở Hồng Kông hoặc Singapore), thay vì phải kết nối đến máy chủ gốc ở Mỹ. Điều này cắt giảm đáng kể độ trễ Latency gây ra bởi khoảng cách vật lý.

Tối ưu Giao thức TCP/IP và Cấu hình hệ điều hành

Một số tinh chỉnh sâu hơn trong hệ điều hành có thể giúp giảm độ trễ Latency ở mức hệ thống:

- Tối ưu TCP/IP: Thay đổi các tham số như MTU (Maximum Transmission Unit) hoặc tùy chỉnh cài đặt Nagle’s Algorithm (thường được tắt trong chế độ chơi game) để giảm thời gian chờ đợi và gộp gói dữ liệu. Việc này giúp các gói tin nhỏ của game được gửi đi nhanh hơn, giảm Latency.

- Chỉnh sửa DNS: Thay đổi máy chủ DNS mặc định của ISP sang các dịch vụ DNS công cộng nhanh hơn (như Google DNS hoặc Cloudflare DNS) có thể làm giảm Latency ở bước phân giải tên miền.

Ứng dụng thực tiễn của Latency trong mạng và hệ thống

Độ trễ Latency không chỉ là một chỉ số trên máy tính cá nhân; nó là yếu tố quyết định hiệu quả của các hệ thống phức tạp và các công nghệ mới nổi.

Latency trong Cloud Computing

Trong môi trường điện toán đám mây (Thực thể: AWS, Azure, Google Cloud), Latency là một rào cản lớn.

- Multi-Region Deployment: Các công ty sử dụng dịch vụ Cloud Computing luôn chọn vùng (Region) gần khách hàng nhất để giảm độ trễ Latency tối đa.

- Microservices: Khi một ứng dụng được chia thành nhiều dịch vụ nhỏ (microservices), Latency giữa các dịch vụ nội bộ này (Internal Latency) trở nên cực kỳ quan trọng. Latency nhỏ trong từng dịch vụ có thể cộng dồn lại thành độ trễ mạng lớn cho người dùng cuối.

Tác động của Latency đến Công nghệ 5G và IoT

Sự ra đời của 5G và Internet Vạn Vật (IoT) đặt mục tiêu thách thức về Zero Latency (Độ trễ gần bằng 0).

- 5G: Công nghệ 5G được thiết kế để đạt Latency lý tưởng chỉ 1ms. Mức độ trễ Latency này là điều kiện tiên quyết để vận hành xe tự lái, phẫu thuật từ xa và các nhà máy thông minh, nơi sự trễ 100ms có thể gây ra thảm họa.

- IoT (Internet of Things): Các cảm biến và thiết bị IoT cần phản ứng nhanh với môi trường. Độ trễ Latency thấp đảm bảo hệ thống an ninh, kiểm soát nhiệt độ, hoặc robot sản xuất hoạt động tức thời và chính xác.

So sánh Latency với các chỉ số Bandwidth, Jitter

Để có cái nhìn toàn diện về hiệu suất mạng, chúng ta cần hiểu rõ mối quan hệ và sự khác biệt giữa Latency và các chỉ số mạng quan trọng khác.

| Chỉ số | Latency (Độ trễ) | Bandwidth (Băng thông) | Jitter (Độ lệch trễ) |

|---|---|---|---|

| Định nghĩa | Thời gian cần thiết để gói dữ liệu đi và về (RTT). | Tốc độ truyền tối đa của dữ liệu qua kết nối. | Sự biến động (không ổn định) của Latency theo thời gian. |

| Đơn vị đo | mili giây (ms). | Mbps hoặc Gbps (Megabit/Gigabit mỗi giây). | ms (Độ lệch chuẩn). |

| Ví dụ Analog | Thời gian phản hồi của tài xế xe tải (mất bao lâu để đi). | Độ rộng của đường cao tốc (chở được bao nhiêu xe). | Việc xe tải đôi khi đến sớm, đôi khi đến rất muộn. |

| Tác động chính | Ảnh hưởng đến tính tương tác (game, video call). | Ảnh hưởng đến tốc độ tải (download, stream 4K). | Ảnh hưởng đến chất lượng âm thanh/hình ảnh (gói dữ liệu đến không theo thứ tự). |

Latency khác gì bandwidth?

Đây là câu hỏi thường gặp. Bạn có thể có một đường truyền Bandwidth rất rộng (như đường cao tốc 10 làn), cho phép bạn tải nhiều file cùng lúc, nhưng nếu Latency cao (xe đi chậm), thì thời gian phản hồi ban đầu vẫn rất lâu.

- Bandwidth tốt cho việc tải file lớn.

- Latency tốt cho các tương tác nhỏ và liên tục.

Mối quan hệ giữa Ping và Latency

Như đã phân tích ở trên, mối quan hệ này là một Thực thể có mối quan hệ rõ ràng: Ping là phép đo của Latency. Khi bạn nói “Ping tôi 50ms”, nghĩa là bạn đang nói “độ trễ Latency của tôi là 50ms”.

Công nghệ và xu hướng mới trong việc tối ưu Latency

Các nhà khoa học và kỹ sư đang không ngừng tìm kiếm giải pháp để đẩy độ trễ Latency xuống mức thấp nhất có thể. Fast Byte nhận thấy hai xu hướng công nghệ sau đây là trọng tâm.

Edge Computing (Điện toán Biên)

Đây là một trong những nỗ lực lớn nhất nhằm giảm Latency do khoảng cách.

- Nguyên tắc: Thay vì gửi toàn bộ dữ liệu lên các trung tâm dữ liệu Cloud Computing ở xa (ví dụ: Mỹ hoặc Châu Âu), Edge Computing đặt các máy chủ mini, có khả năng xử lý dữ liệu, gần người dùng hơn (tại các trạm viễn thông, nhà máy, hoặc ngay trong thành phố).

- Lợi ích: Bằng cách xử lý dữ liệu ngay tại “biên” (Edge) của mạng, dữ liệu chỉ cần di chuyển quãng đường ngắn, loại bỏ đáng kể Latency dài. Điều này cực kỳ quan trọng cho các ứng dụng IoT và AI cần phản ứng nhanh.

Mạng 6G và Tối ưu hóa Giao thức Mạng

Trong tương lai gần, mạng 6G hứa hẹn sẽ đưa Latency xuống dưới mức 1ms (Zero Latency), mở ra kỷ nguyên của kết nối gần như tức thời.

Các giao thức mạng mới đang được nghiên cứu để giảm thiểu các bước bắt tay (handshake) và kiểm tra lỗi của TCP/IP truyền thống, giúp truyền tải dữ liệu nhanh hơn mà vẫn đảm bảo độ tin cậy.

Lời khuyên để duy trì Latency thấp hiệu quả

Duy trì độ trễ Latency thấp là một quá trình liên tục, không chỉ là giải pháp một lần. Đây là các lời khuyên thực tế từ đội ngũ kỹ thuật của Fast Byte.

Kiểm tra và ưu tiên QoS (Quality of Service)

- QoS là tính năng có sẵn trên hầu hết các router hiện đại, cho phép bạn ưu tiên băng thông và Latency cho một số ứng dụng hoặc thiết bị nhất định.

- Hành động: Nếu bạn đang chơi game, hãy đặt game đó vào danh sách ưu tiên cao nhất trong cài đặt QoS của router. Điều này đảm bảo rằng ngay cả khi có người khác đang xem video 4K, gói dữ liệu game của bạn vẫn được xử lý và gửi đi với độ trễ Latency thấp nhất.

Thường xuyên kiểm tra và bảo trì mạng

- Quét virus/malware: Các phần mềm độc hại chạy ngầm có thể chiếm dụng tài nguyên hệ thống và làm tăng độ trễ Latency do tiêu thụ băng thông ngầm.

- Cập nhật Driver mạng: Driver mạng cũ có thể không tương thích với các giao thức mạng mới, dẫn đến việc xử lý gói dữ liệu không hiệu quả và gây tăng Latency.

Chọn đúng Server và Vị trí

Đối với game thủ và người dùng chuyên nghiệp:

- Chọn server gần nhất: Luôn chọn máy chủ game hoặc máy chủ Cloud Computing có vị trí vật lý gần bạn nhất để giảm Latency do khoảng cách.

- Tránh giờ cao điểm: Nếu bạn không thể nâng cấp đường truyền, hãy cân nhắc sử dụng mạng cho các tác vụ quan trọng vào các khung giờ ít người dùng để giảm độ trễ mạng do tắc nghẽn ISP.

Các sai lầm thường gặp khi xử lý Latency

Khi cố gắng giảm Latency, người dùng thường mắc phải một số lỗi cơ bản do hiểu sai về bản chất của độ trễ mạng và cách thức hoạt động của các chỉ số liên quan.

Sai lầm 1: Nhầm lẫn giữa Latency và Bandwidth

Đây là sai lầm phổ biến nhất. Rất nhiều người dùng than phiền về Latency cao (mạng lag) nhưng lại tập trung vào việc nâng cấp Bandwidth (tăng tốc độ tải).

Việc tăng tốc độ tải từ 100Mbps lên 500Mbps gần như không giúp giảm độ trễ Latency đi một mili giây nào, vì Latency không phụ thuộc vào Bandwidth. Thay vào đó, bạn nên đầu tư vào các giải pháp định tuyến (router) tốt hơn hoặc sử dụng CDN.

Sai lầm 2: Quan niệm “Cáp quang luôn giảm Latency”

Cáp quang giúp giảm độ trễ Latency vì dữ liệu di chuyển bằng ánh sáng, nhưng độ trễ mạng vẫn bị chi phối bởi khoảng cách và số lượng thiết bị chuyển tiếp.

Dù bạn dùng cáp quang, nếu bạn kết nối đến một máy chủ ở bên kia bán cầu, Latency vẫn sẽ cao do quãng đường vật lý quá xa. Việc chuyển từ cáp đồng sang cáp quang chỉ là giải pháp tối ưu, không phải là giải pháp triệt để cho Latency.

Sai lầm 3: Chỉ nhìn vào con số Ping lần đầu

Nhiều người chỉ chạy Ping một lần duy nhất và cho rằng đó là độ trễ Latency ổn định của mạng.

Latency luôn dao động. Bạn cần chạy Ping liên tục (ví dụ: ping -t google.com) để theo dõi sự ổn định của độ trễ mạng (Jitter). Một kết nối tốt phải có Latency thấp và ổn định.

FAQs (Hỏi đáp nhanh)

Latency bao nhiêu là tốt cho các tác vụ khác nhau?

Độ trễ Latency được coi là tốt tùy thuộc vào yêu cầu của ứng dụng:

- Tuyệt vời (1 – 30ms): Lý tưởng cho mọi loại game đối kháng (FPS, MOBA) và giao dịch tài chính tốc độ cao.

- Tốt (30 – 50ms): Tốt cho hầu hết các game trực tuyến, video streaming chất lượng cao và duyệt web thông thường.

- Chấp nhận được (50 – 100ms): Có thể chấp nhận cho duyệt web, gửi email, nhưng bắt đầu có độ trễ nhận thấy được trong game.

- Cao (> 100ms): Gây ra game lag/ping cao, làm gián đoạn cuộc gọi video và làm chậm đáng kể trải nghiệm tải trang.

Độ trễ Latency có phải là Ping không?

Không hoàn toàn. Về mặt kỹ thuật, Ping là một công cụ đo latency. Ping gửi một gói tin ICMP và đo thời gian đi và về (Latency). Do đó, con số Ping mà bạn thấy chính là giá trị Latency (RTT) của kết nối đó.

Làm cách nào để kiểm tra Latency đến một máy chủ cụ thể?

Bạn có thể sử dụng lệnh tracert (Windows) hoặc traceroute (macOS/Linux). Lệnh này không chỉ đo Latency tổng thể mà còn cho bạn biết độ trễ Latency tại mỗi bước nhảy (hop) trên đường đi của gói dữ liệu, từ thiết bị của bạn đến máy chủ đích. Điều này giúp xác định chính xác nút thắt cổ chai gây ra Latency cao.

Các yếu tố nào ảnh hưởng đến Latency mà tôi không thể kiểm soát?

Bạn không thể kiểm soát Latency do:

- Khoảng cách vật lý đến máy chủ (trừ khi máy chủ di chuyển).

- Độ trễ Latency của máy chủ đích (Latency do xử lý của ứng dụng tại Server).

- Tắc nghẽn xảy ra tại các điểm trao đổi Internet lớn (IXP) hoặc cáp quang dưới biển, là những thực thể mà chỉ có các ISP lớn mới can thiệp được.

Qua bài viết này, hy vọng bạn đã có cái nhìn toàn diện và sâu sắc về “Latency là gì“, vai trò tối quan trọng của độ trễ mạng đối với mọi trải nghiệm số, từ chơi game giải trí đến các ứng dụng Cloud Computing phức tạp.

Latency không chỉ là một thuật ngữ kỹ thuật, mà là thước đo cho chất lượng tương tác của bạn với thế giới số. Việc tối ưu Latency bằng cách sử dụng CDN, tối ưu TCP/IP hay đơn giản là chuyển sang kết nối dây là những bước thiết yếu để bạn luôn tận hưởng tốc độ Internet tốt nhất.

Fast Byte tin rằng, trong tương lai, với sự phát triển của Edge Computing và mạng 6G, mục tiêu Zero Latency sẽ trở thành hiện thực, mở ra những khả năng không giới hạn cho công nghệ và đời sống.