Load Balancer được ví như là “người điều phối giao thông” giúp phân phối lưu lượng truy cập đồng đều giữa nhiều máy chủ, đảm bảo hệ thống luôn ổn định và mượt mà. Bài viết sẽ giải thích Load Balancer là gì, cơ chế hoạt động, các loại Load Balancer (L4, L7, GSLB), những thuật toán phân phối phổ biến, lợi ích mang lại, ứng dụng thực tế cùng cách triển khai hiệu quả cho doanh nghiệp.

Load Balancer là gì?

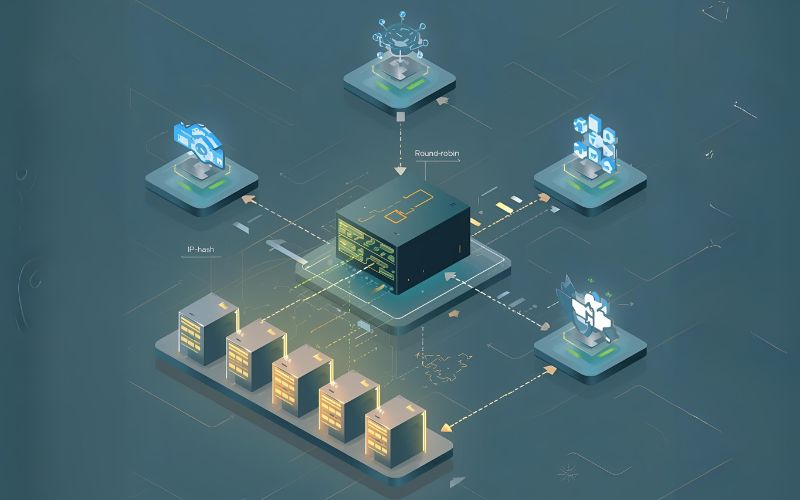

Load Balancer là một thiết bị vật lý hoặc một ứng dụng phần mềm hoạt động như một “người điều phối giao thông” thông minh. Thay vì để các yêu cầu từ người dùng trực tiếp đến các máy chủ ứng dụng (Application Servers), mọi yêu cầu đều đi qua Load Balancer.

Load Balancer thực hiện ba nhiệm vụ cốt lõi:

- Chấp nhận lưu lượng truy cập từ người dùng và quyết định nơi sẽ gửi yêu cầu đó.

- Phân phối yêu cầu đến các máy chủ backend (backend servers) dựa trên một thuật toán đã định.

- Giám sát liên tục tình trạng của các máy chủ để đảm bảo chỉ gửi lưu lượng đến các máy chủ đang hoạt động (Healthy Servers).

Đối với người dùng, sự tồn tại của nhiều máy chủ là hoàn toàn vô hình, họ chỉ tương tác với một địa chỉ IP hoặc tên miền duy nhất được quản lý bởi Load Balancer. Việc áp dụng Load Balancer giúp chúng ta tận dụng tối đa sức mạnh của toàn bộ cụm máy chủ (Server Cluster).

Vì sao cần sử dụng Load Balancing?

Khi một doanh nghiệp phát triển, lượng khách hàng và lưu lượng truy cập tăng lên là điều không thể tránh khỏi. Việc sử dụng một máy chủ duy nhất cho hệ thống sẽ sớm bộc lộ nhược điểm, đặc biệt trong các chiến dịch marketing lớn hoặc các sự kiện mua sắm cao điểm. Lúc này, câu hỏi “Load Balancer có tác dụng gì?” trở nên thiết yếu.

Load Balancer được coi là một thành phần không thể thiếu trong kiến trúc hệ thống hiện đại vì nó giải quyết các vấn đề sau:

- Nguy cơ quá tải (Overload): Nếu lưu lượng tăng đột ngột, một máy chủ sẽ không đủ tài nguyên (CPU, RAM, băng thông) để xử lý tất cả các yêu cầu. Load Balancer đảm bảo lưu lượng được trải đều, ngăn chặn tình trạng quá tải cục bộ.

- Điểm lỗi duy nhất (Single Point of Failure – SPOF): Nếu máy chủ duy nhất gặp sự cố, toàn bộ dịch vụ sẽ ngừng hoạt động. Với giải pháp Load Balancing, nếu một máy chủ bị lỗi, Load Balancer sẽ tự động chuyển hướng lưu lượng sang các máy chủ còn lại, duy trì dịch vụ liên tục (đảm bảo tính sẵn sàng cao).

- Tối ưu chi phí phần cứng: Thay vì đầu tư một máy chủ vật lý quá mạnh và đắt đỏ, doanh nghiệp có thể sử dụng nhiều máy chủ có cấu hình vừa phải hơn (tăng khả năng mở rộng linh hoạt), vừa tiết kiệm chi phí ban đầu vừa dễ dàng nâng cấp sau này.

Nhờ những lợi ích của Load Balancer, các chuyên gia DevOps và System Architect luôn ưu tiên đưa giải pháp này vào thiết kế hệ thống để đảm bảo dịch vụ luôn ở trạng thái hoạt động tốt nhất, bất kể lưu lượng truy cập thay đổi như thế nào.

Cơ chế hoạt động của Load Balancer

Để hiểu được cách Load Balancer hoạt động, chúng ta cần đi sâu vào quy trình phân phối lưu lượng và các cơ chế hỗ trợ đi kèm.

Cách phân phối yêu cầu truy cập

Khi một người dùng gửi yêu cầu truy cập đến một ứng dụng web, yêu cầu đó sẽ đi qua Load Balancer (IP Public của Load Balancer). Load Balancer không xử lý yêu cầu đó, mà thay vào đó, nó hoạt động như một máy chủ proxy:

- Tiếp nhận: Load Balancer nhận gói tin TCP/IP hoặc HTTP từ người dùng.

- Lựa chọn: Nó áp dụng một thuật toán cân bằng tải (ví dụ: Round Robin hoặc Least Connections) để xác định máy chủ backend nào sẽ xử lý yêu cầu.

- Chuyển tiếp: Load Balancer chuyển tiếp yêu cầu đến máy chủ được chọn. Quá trình này được thực hiện rất nhanh, gần như không tạo thêm độ trễ đáng kể.

- Phản hồi: Máy chủ backend xử lý yêu cầu và gửi phản hồi trở lại Load Balancer. Load Balancer sau đó chuyển phản hồi đó về cho người dùng ban đầu.

Quá trình này đảm bảo rằng mỗi máy chủ trong cụm máy chủ đều được chia sẻ công việc một cách hợp lý, tối ưu hóa hiệu suất tổng thể.

Health Check và giám sát máy chủ

Một trong những chức năng thông minh nhất của Load Balancer là Health Check (Kiểm tra trạng thái sức khỏe).

Load Balancer liên tục gửi các tín hiệu hoặc yêu cầu kiểm tra (probes) đến từng máy chủ backend trong nhóm. Nếu máy chủ phản hồi một cách hợp lệ (ví dụ: trả về mã trạng thái HTTP 200 OK), Load Balancer coi máy chủ đó là Healthy (khỏe mạnh) và tiếp tục gửi lưu lượng đến máy chủ đó.

Ngược lại, nếu một máy chủ không phản hồi, phản hồi chậm, hoặc trả về lỗi, Load Balancer sẽ đánh dấu máy chủ đó là Unhealthy (không khỏe) và ngay lập tức dừng gửi bất kỳ yêu cầu mới nào đến nó.

Cơ chế Health Check này là nền tảng cho việc đảm bảo độ sẵn sàng cao (High Availability). Khi máy chủ lỗi được sửa chữa và bắt đầu phản hồi lại thành công, Load Balancer sẽ tự động đưa nó trở lại nhóm phục vụ. Đây chính là cách Load Balancer duy trì dịch vụ liên tục mà không cần can thiệp thủ công.

Sticky Session và Session Persistence

Trong nhiều ứng dụng web (ví dụ: giỏ hàng thương mại điện tử, phiên đăng nhập), thông tin về phiên (session data) của người dùng được lưu trữ cục bộ trên máy chủ đã xử lý yêu cầu đầu tiên.

Nếu yêu cầu tiếp theo của người dùng đó bị chuyển hướng sang một máy chủ khác, phiên làm việc sẽ bị mất, gây ra lỗi hoặc buộc người dùng phải đăng nhập lại. Để tránh điều này, Load Balancer sử dụng cơ chế Sticky Session (Phiên dính) hay còn gọi là Session Persistence (Duy trì phiên).

- Cơ chế: Khi một yêu cầu truy cập lần đầu đến, Load Balancer chọn một máy chủ (ví dụ: Server A). Load Balancer sau đó tạo một cookie hoặc ghi nhớ địa chỉ IP của người dùng.

- Hoạt động: Đối với tất cả các yêu cầu tiếp theo từ cùng một người dùng (cùng cookie hoặc IP), Load Balancer sẽ đảm bảo rằng chúng luôn được gửi đến cùng một máy chủ đã xử lý yêu cầu ban đầu (Server A).

Điều này rất quan trọng đối với các ứng dụng đòi hỏi tính tương tác cao, giúp giữ lại dữ liệu phiên và mang lại trải nghiệm liền mạch cho người dùng.

Lợi ích chính khi triển khai Load Balancing

Việc triển khai Load Balancing mang lại những lợi ích chiến lược và kỹ thuật không thể phủ nhận cho bất kỳ hệ thống sản xuất nào có lưu lượng lớn. Đây là câu trả lời toàn diện cho những ai thắc mắc về vai trò của Load Balancer.

Tối ưu hiệu suất và tốc độ phản hồi

Bằng cách phân phối đồng đều lưu lượng truy cập, Load Balancer đảm bảo không có máy chủ nào hoạt động quá công suất, điều này giúp giảm độ trễ (latency) của từng yêu cầu. Khi CPU, RAM và tài nguyên mạng của từng máy chủ được sử dụng dưới ngưỡng tối đa, chúng có thể xử lý các tác vụ nhanh hơn và hiệu quả hơn.

Thống kê cho thấy, việc cải thiện tốc độ phản hồi website dù chỉ vài trăm mili giây cũng có thể tăng tỷ lệ chuyển đổi (conversion rate) và giảm tỷ lệ thoát (bounce rate) đáng kể. Load Balancer trực tiếp cải thiện tốc độ phản hồi, từ đó nâng cao trải nghiệm người dùng và gián tiếp hỗ trợ hoạt động kinh doanh.

Đảm bảo tính sẵn sàng và giảm downtime

Đây là lợi ích quan trọng nhất và thường được nhắc đến trong các cuộc thảo luận về Load Balancer. Khả năng đảm bảo tính sẵn sàng (High Availability) của hệ thống được thực hiện qua hai cách:

- Tự động phát hiện lỗi: Như đã đề cập ở phần Health Check, Load Balancer cô lập máy chủ bị lỗi.

- Khả năng chịu lỗi (Fault Tolerance): Khi một máy chủ gặp sự cố (downtime), Load Balancer sẽ chuyển tất cả lưu lượng đến các máy chủ còn lại đang hoạt động. Ngay cả khi 50% số máy chủ bị lỗi, dịch vụ vẫn tiếp tục hoạt động, mặc dù có thể chậm hơn một chút.

Việc giảm downtime này là cứu cánh cho các ứng dụng quan trọng như ngân hàng, y tế hoặc sàn giao dịch tài chính, nơi mà mỗi giây ngừng hoạt động đều có thể gây thiệt hại lớn.

Khả năng mở rộng linh hoạt

Load Balancer hỗ trợ hai phương pháp mở rộng chính:

- Vertical Scaling (Mở rộng theo chiều dọc): Nâng cấp tài nguyên (CPU, RAM) cho một máy chủ hiện có.

- Horizontal Scaling (Mở rộng theo chiều ngang): Thêm nhiều máy chủ có cấu hình tương tự vào cụm máy chủ.

Load Balancer đặc biệt xuất sắc trong việc hỗ trợ Horizontal Scaling. Khi lưu lượng tăng, bạn chỉ cần thêm một máy chủ mới vào nhóm backend, thông báo cho Load Balancer, và lưu lượng sẽ ngay lập tức được phân phối đến máy chủ mới này.

Khả năng mở rộng linh hoạt (Scalability) này giúp doanh nghiệp dễ dàng đối phó với sự tăng trưởng theo mùa vụ hoặc các chiến dịch đột xuất.

Nâng cao bảo mật cho hạ tầng

Load Balancer đóng vai trò là lớp phòng thủ đầu tiên, đặc biệt là các Load Balancer hoạt động ở L7.

- Tường lửa và DDoS: Nhiều giải pháp Load Balancer hiện đại tích hợp các tính năng bảo mật, giúp lọc bỏ lưu lượng độc hại, chống lại các cuộc tấn công DDoS (Distributed Denial of Service) bằng cách từ chối hoặc giới hạn các yêu cầu bất thường trước khi chúng chạm tới máy chủ ứng dụng.

- SSL Offloading: Load Balancer có thể đảm nhận nhiệm vụ mã hóa và giải mã SSL/TLS (Secure Socket Layer), giúp giảm tải tính toán cho các máy chủ backend (làm giảm gánh nặng xử lý mã hóa), từ đó tối ưu hiệu suất toàn hệ thống.

Nhờ chức năng này, Load Balancer không chỉ tối ưu hóa mà còn nâng cao bảo mật cho hạ tầng ứng dụng.

Quản trị và giám sát tập trung

Load Balancer cung cấp một điểm giao diện duy nhất để giám sát hạ tầng và quản lý hiệu suất của tất cả các máy chủ backend. Thay vì phải kiểm tra từng máy chủ riêng lẻ, quản trị viên hệ thống (System Administrator) có thể:

- Theo dõi chỉ số hiệu suất của toàn bộ cụm máy chủ.

- Nhận thông báo khi một máy chủ bị đánh dấu là Unhealthy.

- Dễ dàng thêm hoặc xóa máy chủ khỏi vòng quay dịch vụ.

Khả năng quản trị và giám sát tập trung này giúp các đội ngũ DevOps và SysAdmin phản ứng nhanh chóng với sự cố và thực hiện các tác vụ bảo trì mà không làm gián đoạn dịch vụ.

Phân loại các Load Balancer

Khi tìm hiểu Load Balancer là gì, điều quan trọng là phải phân biệt được các loại hình phổ biến, vì mỗi loại phục vụ một mục đích khác nhau trong kiến trúc mạng. Sự khác biệt lớn nhất nằm ở lớp mạng (Layer) mà Load Balancer hoạt động.

Cân bằng tải Layer 4 (L4)

Load Balancer L4 hoạt động ở Lớp Vận chuyển (Layer 4) của mô hình OSI, chủ yếu xử lý lưu lượng dựa trên thông tin trong header của gói tin TCP hoặc UDP (Transmission Control Protocol/User Datagram Protocol).

- Cơ chế: Quyết định định tuyến dựa trên địa chỉ IP nguồn/đích và Cổng (Port).

- Ưu điểm: Cực kỳ nhanh và hiệu quả, vì nó không cần kiểm tra nội dung bên trong gói tin. Độ trễ thấp.

- Nhược điểm: Không thể đưa ra quyết định dựa trên nội dung cụ thể của yêu cầu (ví dụ: URL, Cookie, Header HTTP).

- Ứng dụng: Thường được dùng cho các giao dịch đơn giản, tốc độ cao như DNS, hoặc lưu lượng TCP thuần túy.

Cân bằng tải Layer 7 (L7)

Load Balancer L7 hoạt động ở Lớp Ứng dụng (Layer 7) của mô hình OSI, nơi các giao thức HTTP/HTTPS được xử lý.

- Cơ chế: Load Balancer L7 mở và kiểm tra nội dung của gói tin. Nó có thể định tuyến yêu cầu dựa trên bất kỳ thông tin nào trong yêu cầu HTTP, chẳng hạn như URL (

/images/đi tới Server A,/checkout/đi tới Server B), loại thiết bị, hoặc cookie. - Ưu điểm: Cung cấp khả năng định tuyến thông minh và linh hoạt nhất (Content-based Routing). Hỗ trợ SSL Offloading và Sticky Session hiệu quả hơn.

- Nhược điểm: Yêu cầu nhiều tài nguyên tính toán hơn và có độ trễ cao hơn một chút so với L4 vì phải xử lý nội dung gói tin.

- Ứng dụng: Lý tưởng cho các ứng dụng web phức tạp, hệ thống microservices và containers, API Gateway.

Cân bằng tải toàn cầu (GSLB)

GSLB (Global Server Load Balancing) là một dạng Load Balancing tiên tiến, hoạt động ở cấp độ địa lý (Global).

- Cơ chế: GSLB phân phối lưu lượng truy cập của người dùng đến các trung tâm dữ liệu (Data Center) khác nhau trên toàn cầu. Nó thường được triển khai bằng cách sử dụng DNS (Domain Name System).

- Mục tiêu: Tối ưu hóa trải nghiệm người dùng bằng cách định tuyến họ đến trung tâm dữ liệu gần nhất (giảm độ trễ) hoặc đến trung tâm dữ liệu có hiệu suất tốt nhất vào thời điểm đó.

- Độ sẵn sàng: GSLB còn đóng vai trò quan trọng trong các chiến lược phục hồi thảm họa (Disaster Recovery), đảm bảo nếu một Data Center gặp sự cố, lưu lượng sẽ tự động chuyển sang Data Center ở khu vực khác.

So sánh phần cứng, phần mềm và Load Balancer trên đám mây

Việc so sánh Load Balancer dựa trên hình thức triển khai là yếu tố quyết định đối với nhiều doanh nghiệp.

| Loại Load Balancer | Ưu điểm | Nhược điểm | Phù hợp với |

|---|---|---|---|

| Phần cứng (Hardware) | Hiệu suất cực cao (xử lý hàng triệu kết nối), tính năng bảo mật tích hợp sâu (ví dụ: F5 Load Balancer). | Chi phí rất cao, tính linh hoạt kém, mất thời gian cấu hình và bảo trì vật lý. | Các doanh nghiệp lớn, hệ thống ngân hàng, viễn thông có lưu lượng cực kỳ lớn và ổn định. |

| Phần mềm (Software) | Chi phí thấp (miễn phí như Nginx, HAProxy), linh hoạt, dễ dàng mở rộng theo chiều ngang. | Hiệu suất phụ thuộc vào phần cứng máy chủ chạy phần mềm đó, cần kiến thức kỹ thuật để cấu hình. | Các startup, doanh nghiệp vừa và nhỏ, kiến trúc Microservices và DevOps. |

| Trên đám mây (Cloud) | Dễ dàng triển khai và quản lý (Managed Service), tự động co giãn (Auto Scaling), tính sẵn sàng cao tích hợp (ví dụ: AWS ELB). | Chi phí vận hành có thể tăng cao theo lưu lượng, phụ thuộc vào nhà cung cấp Cloud. | Các doanh nghiệp chạy ứng dụng trên Cloud (AWS, GCP, Azure), cần tốc độ triển khai và khả năng mở rộng linh hoạt nhanh chóng. |

Các thuật toán phân phối phổ biến

Thuật toán là “bộ não” của Load Balancer, quyết định yêu cầu sẽ được gửi đến máy chủ nào. Sự lựa chọn thuật toán ảnh hưởng trực tiếp đến hiệu suất và sự cân bằng của toàn bộ cụm máy chủ. Dưới đây là các thuật toán cân bằng tải được sử dụng rộng rãi.

Round Robin (Xoay vòng)

- Cơ chế: Phân phối các yêu cầu đến các máy chủ theo một vòng lặp tuần tự (Server 1, Server 2, Server 3, rồi lại quay lại Server 1).

- Ưu điểm: Rất đơn giản, dễ triển khai và đảm bảo cân bằng tải tuyệt đối về mặt số lượng yêu cầu.

- Nhược điểm: Không tính đến khả năng xử lý thực tế của từng máy chủ. Nếu Server 1 yếu hơn Server 2, cả hai vẫn nhận số lượng yêu cầu bằng nhau, dẫn đến Server 1 bị quá tải.

- Ứng dụng: Thích hợp cho các cụm máy chủ có cấu hình phần cứng đồng nhất.

Weighted Round Robin (Xoay vòng có trọng số)

- Cơ chế: Đây là một phiên bản cải tiến của Round Robin. Quản trị viên chỉ định một “trọng số” (weight) cho mỗi máy chủ dựa trên khả năng xử lý của nó.

- Ví dụ: Nếu Server A có trọng số 3 và Server B có trọng số 1, thì Server A sẽ nhận gấp ba lần số yêu cầu so với Server B.

- Ưu điểm: Cho phép cân bằng tải dựa trên khả năng thực tế của phần cứng, tận dụng tối đa các máy chủ mạnh hơn.

- Ứng dụng: Phù hợp cho cụm máy chủ có cấu hình không đồng nhất.

Least Connections (Ít kết nối nhất)

- Cơ chế: Load Balancer sẽ kiểm tra số lượng kết nối đang hoạt động (active connections) trên mỗi máy chủ và gửi yêu cầu mới đến máy chủ có số lượng kết nối thấp nhất.

- Ưu điểm: Thuật toán này rất thông minh vì nó phản ánh chính xác trạng thái tải hiện tại của các máy chủ. Đây là một trong những cách tốt nhất để tối ưu hiệu suất và tốc độ phản hồi.

- Nhược điểm: Phức tạp hơn Round Robin một chút và đòi hỏi Load Balancer phải liên tục theo dõi trạng thái kết nối.

- Ứng dụng: Lý tưởng cho các ứng dụng có các phiên kết nối kéo dài (long-lived sessions), nơi số lượng kết nối là thước đo tải chính xác.

Least Response Time (Thời gian phản hồi ngắn nhất)

- Cơ chế: Load Balancer gửi yêu cầu đến máy chủ không chỉ có ít kết nối nhất mà còn có thời gian phản hồi ngắn nhất (hoặc thời gian phản hồi trung bình).

- Ưu điểm: Mang lại hiệu suất tối ưu cho người dùng cuối vì luôn ưu tiên máy chủ phản hồi nhanh nhất.

- Nhược điểm: Yêu cầu Load Balancer liên tục đo lường hiệu suất, có thể tạo ra overhead nhỏ.

- Ứng dụng: Phù hợp cho các dịch vụ yêu cầu tốc độ phản hồi cực nhanh như giao dịch tài chính hoặc dịch vụ thời gian thực.

IP Hash (Định tuyến theo địa chỉ IP)

- Cơ chế: Load Balancer tạo ra một hàm băm (hash) dựa trên địa chỉ IP nguồn của người dùng. Dựa vào kết quả băm này, yêu cầu sẽ luôn được gửi đến cùng một máy chủ cụ thể.

- Ưu điểm: Tự động thực hiện Session Persistence (duy trì phiên) mà không cần dùng cookie hay các cơ chế phức tạp khác.

- Nhược điểm: Nếu một máy chủ bị lỗi, tất cả người dùng có IP được băm đến máy chủ đó sẽ bị mất kết nối và phải chờ máy chủ đó phục hồi.

- Ứng dụng: Khi cần đảm bảo một người dùng luôn tương tác với cùng một máy chủ trong suốt phiên làm việc.

Custom Load (Tuỳ chỉnh theo tài nguyên server)

- Cơ chế: Thay vì dựa vào các chỉ số mạng đơn thuần, Load Balancer (thường là các Load Balancer phần mềm) có thể truy vấn chỉ số tài nguyên thực tế của máy chủ như mức sử dụng CPU, RAM, hoặc dung lượng hàng đợi xử lý.

- Ưu điểm: Cung cấp khả năng cân bằng tải chính xác và thông minh nhất, phản ánh trung thực tải trọng của từng máy chủ.

- Ứng dụng: Phù hợp cho các hệ thống microservices phức tạp hoặc môi trường đòi hỏi điều chỉnh tải trọng cực kỳ chi tiết.

Ứng dụng thực tế của Load Balancer

Load Balancer không chỉ giới hạn ở việc cân bằng tải cho các website đơn thuần. Các ứng dụng load balancer đã mở rộng sang nhiều lĩnh vực phức tạp trong kiến trúc hệ thống hiện đại.

Website và ứng dụng thương mại điện tử

Trong lĩnh vực E-commerce, việc đảm bảo tính sẵn sàng cao là điều kiện tiên quyết. Các trang web lớn như Tiki, Shopee hay Amazon sử dụng Load Balancer để:

- Phân phối hàng triệu yêu cầu mua hàng, tìm kiếm sản phẩm và thanh toán trong thời gian cao điểm (Flash Sale).

- Đảm bảo rằng nếu máy chủ xử lý giỏ hàng gặp lỗi, khách hàng có thể chuyển sang máy chủ khác mà không bị mất dữ liệu.

- Thực hiện SSL Offloading để tăng tốc độ xử lý các giao dịch an toàn (HTTPS).

Đây là một trong những ứng dụng load balancer cơ bản nhất nhưng cũng quan trọng nhất, nơi hiệu suất và độ tin cậy quyết định doanh thu.

Hệ thống microservices và containers

Trong kiến trúc microservices, một ứng dụng lớn được chia thành hàng trăm dịch vụ nhỏ, độc lập (được đóng gói trong containers như Docker). Load Balancer đóng vai trò cực kỳ quan trọng trong môi trường này:

- Internal Load Balancing: Load Balancer không chỉ xử lý lưu lượng từ bên ngoài (người dùng) mà còn quản lý lưu lượng giữa các dịch vụ nội bộ (service-to-service communication).

- Service Discovery: Các công cụ như Kubernetes (sử dụng Load Balancer tích hợp) giúp các microservices dễ dàng tìm và giao tiếp với nhau.

- Cân bằng tải ở L7 cho phép định tuyến các yêu cầu API dựa trên đường dẫn URL, giúp đưa yêu cầu đến đúng service nhỏ nhất.

Cơ sở dữ liệu và dịch vụ thời gian thực

Mặc dù việc cân bằng tải cho cơ sở dữ liệu (Database) phức tạp hơn so với máy chủ ứng dụng (vì cần duy trì tính nhất quán dữ liệu), Load Balancer vẫn được sử dụng rộng rãi:

- Read/Write Splitting: Load Balancer có thể phân phối các truy vấn đọc (Read Queries) đến các máy chủ bản sao (Read Replicas), trong khi các truy vấn ghi (Write Queries) được gửi đến máy chủ chính (Primary/Master). Điều này giúp tối ưu hiệu suất và tốc độ phản hồi cho Database.

- Real-time Services: Đối với các dịch vụ thời gian thực như trò chuyện trực tuyến, Load Balancer sử dụng thuật toán Least Connections hoặc Least Response Time để đảm bảo các kết nối WebSockets luôn được duy trì và phục vụ bởi máy chủ hiệu quả nhất.

Giải pháp hybrid (kết hợp on-premise và cloud)

Nhiều doanh nghiệp đang chuyển đổi từ hệ thống On-Premise (đặt tại chỗ) sang Cloud (đám mây). Load Balancer đóng vai trò là cầu nối quan trọng trong giải pháp hybrid:

- Load Balancer toàn cầu (GSLB) có thể định tuyến lưu lượng giữa các máy chủ đặt tại Data Center riêng của công ty và các dịch vụ trên AWS hoặc Azure.

- Điều này giúp doanh nghiệp tận dụng khả năng mở rộng linh hoạt của Cloud cho những lúc cao điểm mà vẫn duy trì các hệ thống cốt lõi (Core Systems) tại chỗ.

Một số công cụ Load Balancer phổ biến

Lựa chọn công cụ Load Balancer phù hợp là bước quan trọng trong quá trình triển khai Load Balancing hiệu quả. Thị trường có nhiều giải pháp, từ phần mềm mã nguồn mở miễn phí đến các dịch vụ đám mây có tính năng quản lý cao.

Nginx

Nginx là một trong những phần mềm máy chủ web (web server) và proxy ngược (reverse proxy) phổ biến nhất thế giới.

- Đặc điểm: Nginx có khả năng hoạt động như một Load Balancer L7 mạnh mẽ, xử lý hàng chục nghìn kết nối đồng thời. Nó nổi tiếng với hiệu suất cao và mức tiêu thụ tài nguyên thấp.

- Cơ chế: Thường sử dụng các thuật toán như Round Robin, IP Hash.

- Ưu điểm: Miễn phí, tài liệu phong phú, cộng đồng lớn, dễ tích hợp vào môi trường Linux/DevOps.

- Ứng dụng: Thường dùng cho các website vừa và nhỏ, hoặc như một Load Balancer nội bộ (internal Load Balancer) trong các hệ thống microservices.

HAProxy

HAProxy (High Availability Proxy) được thiết kế chuyên biệt và tối ưu hóa cho việc cân bằng tải (L4 và L7) và proxy TCP/HTTP.

- Đặc điểm: HAProxy được mệnh danh là tiêu chuẩn vàng cho các ứng dụng yêu cầu độ sẵn sàng cao và hiệu suất tối ưu. Nó thường được triển khai ở phía trước các máy chủ web (như Nginx) để đảm nhận vai trò Load Balancing chính.

- Cơ chế: Hỗ trợ đa dạng các thuật toán, bao gồm cả những thuật toán tiên tiến như Least Connections.

- Ưu điểm: Hiệu suất vượt trội, khả năng tùy chỉnh cấu hình sâu, cung cấp nhiều tính năng Health Check và báo cáo trạng thái chi tiết.

- Ứng dụng: Phù hợp cho các ứng dụng có lưu lượng rất lớn, đòi hỏi hiệu suất và độ sẵn sàng cao tuyệt đối.

AWS Elastic Load Balancing

AWS Elastic Load Balancing (ELB) là dịch vụ Load Balancing được quản lý hoàn toàn (Managed Service) của Amazon Web Services.

- Đặc điểm: ELB tự động co giãn quy mô để xử lý bất kỳ lưu lượng truy cập nào. Nó loại bỏ hoàn toàn gánh nặng về quản lý và bảo trì phần cứng/phần mềm Load Balancer.

- Các loại ELB: Application Load Balancer (ALB – L7), Network Load Balancer (NLB – L4), Gateway Load Balancer, và Classic Load Balancer (đã lỗi thời).

- Ưu điểm: Tích hợp sâu với các dịch vụ AWS khác (Auto Scaling, CloudWatch), khả năng mở rộng linh hoạt vô hạn, độ sẵn sàng cao tích hợp sẵn.

- Ứng dụng: Bắt buộc phải có cho các ứng dụng chạy trên AWS, đặc biệt là khi cần cân bằng tải ở L7 thông minh (sử dụng ALB).

Các giải pháp trong nước (VD: Bizfly, Sunteco…)

Bên cạnh các giải pháp toàn cầu, tại Việt Nam cũng có những nhà cung cấp dịch vụ Cloud và hạ tầng cung cấp dịch vụ Load Balancing riêng:

- Đặc điểm: Các giải pháp trong nước thường cung cấp dịch vụ quản lý (Managed) tương tự như ELB, nhưng được đặt tại các Data Center trong nước.

- Ưu điểm: Tối ưu hóa độ trễ (latency) cho người dùng Việt Nam (giảm khoảng cách vật lý), hỗ trợ kỹ thuật nhanh chóng bằng tiếng Việt, tùy chỉnh theo yêu cầu đặc thù của thị trường.

- Ứng dụng: Phù hợp cho các doanh nghiệp có thị trường mục tiêu chủ yếu tại Việt Nam, quan tâm đến việc tối ưu hiệu suất và tốc độ phản hồi cục bộ.

Cách triển khai Load Balancing hiệu quả

Việc triển khai Load Balancing hiệu quả không chỉ là cài đặt một phần mềm hay mua một dịch vụ. Nó là một quá trình bao gồm cấu hình, quản trị, và tối ưu liên tục.

Các bước cấu hình cơ bản

Quá trình cấu hình Load Balancer cơ bản, dù là phần mềm hay cloud, đều tuân theo các bước sau:

- Xác định nhu cầu: Chọn loại Load Balancer (L4 hay L7) dựa trên yêu cầu ứng dụng (ví dụ: cần định tuyến theo URL? Chọn L7).

- Thiết lập Listener: Định nghĩa cổng (port) và giao thức mà Load Balancer sẽ lắng nghe lưu lượng truy cập (ví dụ: Port 80 cho HTTP, Port 443 cho HTTPS).

- Thiết lập Target Group (Nhóm máy chủ đích): Khai báo danh sách các máy chủ backend (địa chỉ IP và cổng) sẽ nhận lưu lượng.

- Cấu hình Health Check: Đặt các thông số để Load Balancer có thể giám sát máy chủ (ví dụ: kiểm tra Port, Path URL, tần suất kiểm tra).

- Chọn Thuật toán: Lựa chọn thuật toán cân bằng tải phù hợp nhất (ví dụ: Least Connections nếu có phiên làm việc dài, Round Robin nếu các máy chủ đồng nhất).

- Triển khai SSL (Nếu cần): Cài đặt chứng chỉ SSL/TLS lên Load Balancer để thực hiện SSL Offloading.

Mẹo quản trị và tối ưu

Để tối ưu hiệu suất và tốc độ phản hồi sau khi triển khai, bạn nên áp dụng các mẹo sau:

- Sử dụng Caching: Cấu hình Load Balancer (đặc biệt là L7) để lưu trữ tạm thời (cache) các nội dung tĩnh (hình ảnh, CSS, JS). Điều này giúp giảm đáng kể số lượng yêu cầu đến máy chủ backend.

- Tối ưu Health Check: Đặt tần suất kiểm tra sức khỏe vừa phải. Nếu quá thường xuyên, nó sẽ tạo ra gánh nặng mạng không cần thiết. Nếu quá chậm, Load Balancer sẽ phản ứng chậm với máy chủ bị lỗi.

- Quản lý Logging: Kích hoạt tính năng ghi nhật ký (logging) trên Load Balancer để theo dõi chi tiết lưu lượng, giúp phân tích nội dung và đo lường hiệu quả về mặt kỹ thuật, tìm ra các vấn đề về phân phối tải.

- Sử dụng Gzip Compression: Kích hoạt nén dữ liệu (Gzip) trên Load Balancer trước khi gửi phản hồi về cho người dùng. Điều này giảm kích thước gói tin và tăng tốc độ tải.

Khi nào nên chọn hardware, software hay cloud load balancer

Việc lựa chọn giải pháp Load Balancer phụ thuộc vào quy mô và ngân sách:

- Cloud Load Balancer (Ví dụ: AWS ELB): Nên chọn khi bạn chạy hoàn toàn trên Cloud, cần khả năng mở rộng linh hoạt tức thời, và muốn tránh gánh nặng quản trị hạ tầng. Phù hợp cho hầu hết các doanh nghiệp hiện đại.

- Software Load Balancer (Ví dụ: Nginx, HAProxy): Nên chọn khi bạn có đội ngũ DevOps mạnh, muốn kiểm soát tuyệt đối cấu hình, và muốn tiết kiệm chi phí cho các ứng dụng có lưu lượng không quá cực đoan. Rất phổ biến cho hệ thống microservices.

- Hardware Load Balancer (Ví dụ: F5): Nên chọn khi bạn là doanh nghiệp lớn (Ngân hàng, Viễn thông) với yêu cầu về hiệu suất tuyệt đối, cam kết dịch vụ (SLA) cực kỳ nghiêm ngặt và sẵn sàng đầu tư chi phí ban đầu rất lớn.

Kết luận

Load Balancer là giải pháp cốt lõi, không thể thiếu cho bất kỳ hệ thống trực tuyến nào hướng đến sự phát triển và ổn định.

Vai trò thiết yếu của Load Balancer trong hạ tầng hiện đại

Chúng ta đã thấy, Load Balancer không chỉ thực hiện nhiệm vụ cân bằng tải đơn thuần. Nó là một cổng dịch vụ thông minh, đảm nhận các vai trò quan trọng từ việc tối ưu hiệu suất và tốc độ phản hồi, đảm bảo tính sẵn sàng cao, cho đến việc nâng cao bảo mật cho hạ tầng và hỗ trợ khả năng mở rộng linh hoạt theo nhu cầu.

Việc hiểu sâu về Load Balancer là gì, các loại L4, L7 và các thuật toán cân bằng tải (như Round Robin hay Least Connections) giúp các chuyên gia công nghệ đưa ra quyết định kiến trúc chính xác, từ đó xây dựng các dịch vụ đáng tin cậy.

Gợi ý định hướng triển khai cho doanh nghiệp

Với các doanh nghiệp Việt Nam, đặc biệt là các startup và công ty công nghệ đang phát triển nhanh, định hướng tối ưu nhất là kết hợp giữa giải pháp Cloud Managed Service (Load Balancer trên đám mây) để tận dụng khả năng mở rộng linh hoạt và sử dụng HAProxy hoặc Nginx làm Load Balancer nội bộ (Internal Load Balancer) cho các dịch vụ bên trong kiến trúc microservices.

Tại Fast Byte, chúng tôi thường khuyến nghị mô hình kết hợp này vì nó mang lại sự cân bằng giữa hiệu suất, chi phí và tính dễ quản lý. Có thể nói, đầu tư vào Load Balancer cũng chính là đầu tư vào chất lượng dịch vụ và sự hài lòng của khách hàng.