Serverless Computing là mô hình Cloud đột phá, nơi nhà cung cấp quản lý toàn bộ hạ tầng máy chủ, cho phép nhà phát triển tập trung 100% vào code. Bài viết này sẽ giải mã Serverless Computing là gì, kiến trúc FaaS/BaaS, phân biệt 2 giai đoạn Cold Start và Warm Start trong Cold Start, phân tích các lợi ích cốt lõi, và so sánh Serverless với các mô hình truyền thống như IaaS/Container để bạn có cái nhìn toàn diện.

Serverless Computing là gì?

Serverless Computing (hay còn gọi là điện toán phi máy chủ) là một mô hình thực thi Cloud mà theo đó, nhà cung cấp dịch vụ Cloud chịu trách nhiệm quản lý hoàn toàn cơ sở hạ tầng máy chủ. Điều này có nghĩa là, với tư cách là nhà phát triển, bạn có thể xây dựng và chạy các ứng dụng mà không cần quan tâm đến việc cung cấp, quản lý hay bảo trì bất kỳ máy chủ nào.

Mặc dù tên gọi là “phi máy chủ” nhưng các máy chủ vật lý vẫn tồn tại. Điểm khác biệt mấu chốt là trách nhiệm quản lý máy chủ đã được chuyển giao hoàn toàn từ người dùng sang nhà cung cấp Cloud (như Amazon Web Services, Microsoft Azure hay Google Cloud Platform).

Quá trình phát triển và xu hướng

Serverless Computing không phải là một công nghệ tĩnh. Kể từ khi AWS Lambda ra mắt vào năm 2014, mô hình này đã có những bước phát triển vượt bậc.

Lịch sử ngắn gọn và sự trưởng thành

Sự ra đời của AWS Lambda đánh dấu cột mốc quan trọng, đưa mô hình FaaS trở thành tiêu chuẩn công nghiệp. Các đối thủ khác nhanh chóng theo sau với Azure Functions và Google Cloud Functions.

Ngày nay, hệ sinh thái Serverless đã trưởng thành với sự hỗ trợ của các công cụ và Framework mạnh mẽ:

- Serverless Framework: Công cụ mã nguồn mở giúp đơn giản hóa việc triển khai và quản lý toàn bộ ứng dụng Serverless Computing trên đa nền tảng Cloud.

- Thư viện Middy (cho Node.js): Giúp quản lý Middlewares, đơn giản hóa code cho AWS Lambda.

Các xu hướng Serverless tương lai

Xu hướng phát triển Serverless Computing đang mở rộng ra ngoài phạm vi FaaS truyền thống:

Serverless Database

Các nhà cung cấp Cloud đã phát triển các cơ sở dữ liệu có khả năng mở rộng và thanh toán theo mức sử dụng. Ví dụ: Amazon Aurora Serverless, cho phép Database của bạn tự động mở rộng năng lực tính toán và thu về 0 khi không có kết nối. Sự kết hợp giữa Serverless Computing (FaaS) và Database Serverless tạo nên kiến trúc hoàn hảo.

Edge Computing và Serverless

Các dịch vụ như CloudFront Functions (AWS) cho phép bạn chạy code Serverless tại các điểm gần người dùng nhất (Edge Locations). Điều này giúp giảm độ trễ về mạng xuống mức tối thiểu, mang lại trải nghiệm người dùng nhanh hơn cho các tác vụ đơn giản như kiểm tra Token truy cập hoặc điều hướng URL.

Kubernetes và Serverless

Sự kết hợp giữa Kubernetes và Serverless Computing đã tạo ra các công cụ như Knative, cho phép bạn chạy các Container theo mô hình Serverless bên trong Cluster Kubernetes của mình. Điều này mang lại sự linh hoạt của Serverless nhưng vẫn giữ được quyền kiểm soát của Container.

Cách thức hoạt động và kiến trúc

Kiến trúc Serverless Computing chủ yếu xoay quanh việc phân tách ứng dụng thành các hàm (Functions) nhỏ, độc lập, được kích hoạt khi có sự kiện xảy ra.

Sự kiện điều khiển (Event-Driven)

Điểm cốt lõi của Serverless Computing là mô hình Event-Driven. Thay vì chạy liên tục, các khối code của bạn (gọi là Functions) sẽ được kích hoạt bởi các sự kiện từ bên ngoài hoặc bên trong hệ thống.

Các loại sự kiện phổ biến:

- HTTP Request: Một yêu cầu truy cập từ trình duyệt hoặc ứng dụng di động.

- Database Change: Một dòng dữ liệu được thêm, cập nhật hoặc xóa trong cơ sở dữ liệu.

- File Upload: Một tệp tin mới được tải lên dịch vụ lưu trữ (ví dụ: S3 Bucket của AWS).

- Scheduled Events: Hàm được kích hoạt theo lịch trình (ví dụ: chạy báo cáo lúc 12 giờ đêm mỗi ngày).

Khi một sự kiện xảy ra, nhà cung cấp Cloud sẽ tự động cấp phát tài nguyên, chạy hàm, và sau đó hủy bỏ tài nguyên đó khi hàm kết thúc. Toàn bộ quá trình này diễn ra chỉ trong vài mili giây.

Hai giai đoạn hoạt động chính (Phân biệt Cold Start và Warm Start)

Serverless Computing có hai trạng thái quan trọng ảnh hưởng trực tiếp đến hiệu suất mà mọi Developer cần nắm rõ:

Giai đoạn 1: Cold Start (Khởi động nguội)

Đây là thời gian từ lúc một sự kiện kích hoạt đến khi hàm bắt đầu thực thi code, khi container chứa hàm đó chưa được cấp phát (hoặc đã bị hủy).

- Quá trình: Nhà cung cấp Cloud cần cấp phát một Container/Runtime Environment mới → Tải code của bạn vào Container đó → Khởi tạo môi trường (ví dụ: JVM cho Java) → Chạy hàm.

- Hậu quả: Gây ra độ trễ đáng kể (thường từ vài trăm mili giây đến vài giây), đặc biệt với các ngôn ngữ có thời gian khởi động lâu (như Java, .NET). Đây là một thách thức và hạn chế lớn của Serverless Computing.

Giai đoạn 2: Warm Start (Khởi động nóng)

Xảy ra khi Container đã được cấp phát và giữ ở trạng thái chờ một thời gian ngắn sau khi thực thi.

- Quá trình: Sự kiện mới đến → Container có sẵn được tái sử dụng → Chạy hàm ngay lập tức.

- Hậu quả: Độ trễ rất thấp (chỉ vài mili giây). Hầu hết các nhà cung cấp Cloud đều duy trì các Warm Container trong một khoảng thời gian nhất định (thường là 5–15 phút).

Mẹo của Fast Byte: Để giải quyết nỗi đau Cold Start Serverless, các DevOps Engineer thường áp dụng chiến lược “thăm dò” (provisioned concurrency) hoặc gửi các yêu cầu giả định (Keep-Alive Pings) để giữ cho các hàm Serverless ở trạng thái Warm.

Đặc trưng nổi bật của Serverless

Bốn đặc trưng sau đây là lý do tại sao Serverless Computing trở thành mô hình được các doanh nghiệp ưu tiên lựa chọn để tối ưu hiệu suất và chi phí:

Không cần quản lý máy chủ (No Server Management)

Đây là đặc điểm cốt lõi và quan trọng nhất của điện toán phi máy chủ. Mọi công việc liên quan đến hạ tầng như:

- Cấp phát tài nguyên.

- Cài đặt hệ điều hành, bản vá bảo mật.

- Quản lý mạng, cấu hình tường lửa.

… đều được nhà cung cấp Cloud đảm nhận. Bạn không bao giờ phải SSH vào một máy chủ Serverless hay lo lắng về việc nâng cấp phần cứng. Điều này giúp các nhóm phát triển tập trung 100% vào Business Logic.

Thanh toán theo mức sử dụng (Pay-per-use)

Mô hình thanh toán này của Serverless Computing mang lại sự khác biệt lớn về mặt tài chính. Thay vì trả tiền cho thời gian máy chủ chạy liên tục (24/7), bạn chỉ trả tiền cho:

- Thời gian thực thi (Execution Time): Tính bằng mili giây.

- Số lần gọi hàm (Number of Requests): Số lần hàm được kích hoạt.

Nếu ứng dụng của bạn không có bất kỳ lưu lượng truy cập nào trong 10 tiếng, chi phí Cloud Bill của bạn sẽ là 0. Đây là lợi ích Serverless vô cùng hấp dẫn đối với các công ty khởi nghiệp có lưu lượng truy cập không ổn định.

Khả năng mở rộng tự động (Native Auto-scaling)

Trong các mô hình truyền thống, bạn phải tự cấu hình Auto-scaling Group. Ngược lại, Serverless Computing xử lý việc mở rộng theo yêu cầu một cách tự động và gần như vô hạn.

Khi lưu lượng truy cập tăng vọt (ví dụ: 1000 yêu cầu/giây), nhà cung cấp Cloud sẽ tự động nhân bản (replicate) các hàm của bạn thành hàng nghìn Container/Instance song song để xử lý tải. Khi lưu lượng giảm, các tài nguyên này sẽ tự động thu hồi.

Tính khả dụng cao tích hợp (Built-in High Availability)

Vì Serverless Computing được quản lý bởi Cloud Provider, các hàm của bạn được tự động phân tán trên nhiều Vùng sẵn có (Availability Zones) trong một khu vực địa lý (Region). Điều này đảm bảo rằng ngay cả khi một khu vực trung tâm dữ liệu gặp sự cố, ứng dụng vẫn tiếp tục chạy mượt mà mà không cần cấu hình phức tạp từ phía người dùng.

Các loại hình dịch vụ Serverless

Serverless Computing là một thuật ngữ rộng bao gồm hai loại hình dịch vụ chính, mỗi loại phục vụ một vai trò khác nhau trong kiến trúc ứng dụng của bạn.

Function as a Service (FaaS) – Chức năng là Dịch vụ

FaaS là cốt lõi của Serverless Computing. Nó cho phép bạn triển khai các đoạn code độc lập (Functions) để thực thi dựa trên các sự kiện. Đây là nơi bạn đặt Business Logic chính của mình.

| Dịch vụ FaaS tiêu biểu | Nhà cung cấp | Ngôn ngữ hỗ trợ |

|---|---|---|

| AWS Lambda | Amazon Web Services (AWS) | Node.js, Python, Java, Go, C#, Ruby… |

| Azure Functions | Microsoft Azure | C#, F#, Node.js, Python, Java, PowerShell… |

| Google Cloud Functions | Google Cloud Platform (GCP) | Node.js, Python, Go, Java, .NET… |

Chuyên gia Fast Byte nhận định: Trong số các dịch vụ FaaS, AWS Lambda là dịch vụ Serverless được sử dụng phổ biến nhất, dẫn đầu thị trường về cả tính năng và hệ sinh thái tích hợp.

Backend as a Service (BaaS) – Backend là Dịch vụ

BaaS cung cấp các dịch vụ backend đã được cấu hình sẵn, Serverless cho phép ứng dụng frontend (Web/Mobile) sử dụng trực tiếp mà không cần code backend tùy chỉnh.

- Ví dụ: Quản lý cơ sở dữ liệu Serverless, xác thực người dùng (Authentication), lưu trữ tệp tin (Storage), và đồng bộ hóa dữ liệu thời gian thực.

- Dịch vụ tiêu biểu: Firebase (Google), AWS Amplify, Azure Mobile Apps.

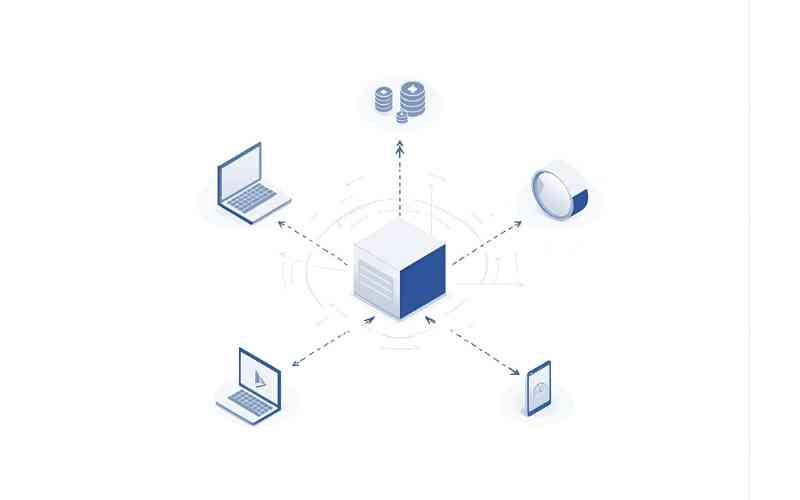

Sơ đồ kiến trúc Serverless đơn giản:

Một ứng dụng Serverless Computing điển hình sẽ kết hợp cả hai:

- Frontend (Client-side code).

- API Gateway → Kích hoạt FaaS (ví dụ: AWS Lambda) để xử lý logic nghiệp vụ.

- FaaS → Tương tác với BaaS (ví dụ: Cơ sở dữ liệu Serverless như DynamoDB) để lưu trữ dữ liệu.

Mối quan hệ giữa FaaS và BaaS là mối quan hệ hỗ trợ chặt chẽ để tạo nên một ứng dụng Serverless hoàn chỉnh.

Lợi ích khi sử dụng Serverless

Áp dụng Serverless Computing có thể mang lại những cải tiến đáng kể, giải quyết trực diện các nỗi đau về chi phí và vận hành của các DevOps Engineer và doanh nghiệp.

Giảm thiểu chi phí vận hành (Operational Cost Reduction)

Lợi ích Serverless lớn nhất là mô hình Pay-per-use. Theo nghiên cứu của Fast Byte về các dự án chuyển đổi Cloud, các ứng dụng có lưu lượng truy cập thất thường hoặc theo đợt có thể giảm chi phí Cloud Bill lên đến 70% khi chuyển từ VM sang Serverless Computing.

Lý do: Bạn chỉ trả tiền cho thời gian thực thi của hàm (thường tính bằng mili giây), thay vì trả tiền cho một máy chủ Virtual Machine (VM) chạy không tải (idle) 24 giờ mỗi ngày, 7 ngày mỗi tuần.

Tăng năng suất làm việc (Increased Developer Productivity)

Với Serverless Computing, nhà phát triển không cần dành thời gian cho các công việc không tạo ra giá trị kinh doanh như:

- Quản lý hệ điều hành, vá lỗi bảo mật.

- Giám sát dung lượng ổ đĩa.

- Cấu hình load balancer.

Mọi tài nguyên đều được quản lý tự động, cho phép các Developer tập trung 100% vào việc phát triển Business Logic, từ đó tăng tốc độ phát triển sản phẩm (Time-to-market).

Tự động mở rộng và quản lý tải (Seamless Scaling)

Như đã đề cập, khả năng tự động mở rộng là một ưu điểm vượt trội. Bất kể lượng yêu cầu là 10 hay 10.000 mỗi giây, hệ thống Serverless Computing sẽ tự động nhân bản các hàm của bạn để xử lý mà không cần sự can thiệp thủ công.

Điều này đặc biệt quan trọng đối với các sự kiện lớn, các chiến dịch marketing ngắn hạn, nơi lưu lượng truy cập tăng vọt đột ngột. Sự linh hoạt này giúp đảm bảo tính khả dụng và trải nghiệm người dùng luôn ở mức cao nhất.

Đơn giản hóa việc triển khai (Simpler Deployment)

Triển khai một hàm Serverless thường đơn giản hơn nhiều so với việc triển khai toàn bộ ứng dụng trên VM hoặc Container. Các công cụ như Serverless Framework hoặc các công cụ tích hợp sẵn của Cloud Provider cho phép bạn đóng gói code và các Dependencies, sau đó triển khai chỉ bằng một lệnh duy nhất. Quá trình này giúp rút ngắn chu kỳ CI/CD.

Thách thức và hạn chế cần biết

Mặc dù Serverless Computing mang lại nhiều lợi ích, mô hình này vẫn đi kèm với các thách thức và hạn chế mà các đội ngũ kỹ thuật cần xem xét kỹ lưỡng trước khi triển khai.

Vấn đề Cold Start (Độ trễ khởi động)

Đây là hạn chế Serverless lớn nhất, đặc biệt ảnh hưởng đến trải nghiệm người dùng. Khi hàm được kích hoạt lần đầu sau một thời gian không hoạt động, độ trễ có thể xảy ra.

- Giải pháp Fast Byte đề xuất:

- Tối ưu Code: Giảm thiểu dung lượng gói code, sử dụng ngôn ngữ khởi động nhanh (Node.js, Python).

- Provisioned Concurrency: Cấu hình để luôn giữ một số lượng Container “ấm” nhất định, đảm bảo độ trễ thấp ngay cả khi không có lưu lượng truy cập. Tuy nhiên, điều này sẽ làm tăng chi phí.

- Tăng dung lượng bộ nhớ (Memory Allocation): Việc cấp phát nhiều bộ nhớ hơn thường đi kèm với việc cấp phát CPU mạnh hơn, giúp giảm thời gian khởi động môi trường.

Giới hạn tài nguyên (Resource Limits)

Các dịch vụ Serverless Computing (như AWS Lambda) có những giới hạn nghiêm ngặt về:

- Thời gian thực thi tối đa (Execution Timeout): Thường từ 15 phút trở xuống. Serverless không phù hợp cho các tác vụ xử lý dài hạn (Long-running processes).

- Dung lượng bộ nhớ (Memory): Có giới hạn (ví dụ: tối đa 10GB).

- Dung lượng gói code: Gói code và các thư viện liên quan phải nhỏ hơn giới hạn quy định.

Đối với các tác vụ xử lý Big Data phức tạp hoặc các ứng dụng cần kiểm soát tài nguyên tuyệt đối, Serverless Computing có thể không phải là lựa chọn tối ưu.

Khó khăn trong Debugging và Monitoring

Việc debug (gỡ lỗi) các hàm Serverless có thể phức tạp hơn so với ứng dụng chạy trên VM.

- Lý do: Code của bạn chạy trong môi trường Container do Cloud Provider quản lý. Bạn không có quyền truy cập trực tiếp vào hệ điều hành.

- Giải pháp: Phải dựa vào hệ thống ghi nhật ký (Logging) và theo dõi (Monitoring) phức tạp (ví dụ: CloudWatch, X-Ray của AWS). Việc tái tạo lại lỗi trong môi trường local cũng là một thách thức.

Sự phụ thuộc vào nhà cung cấp (Vendor Lock-in)

Mỗi nhà cung cấp Cloud có các API và triển khai FaaS khác nhau (AWS Lambda, Azure Functions,…). Việc chuyển đổi ứng dụng Serverless Computing từ nền tảng này sang nền tảng khác có thể đòi hỏi nhiều công sức.

Serverless Framework ra đời một phần để giảm thiểu nỗi đau Vendor Lock-in bằng cách cung cấp một lớp trừu tượng hóa (Abstraction Layer) chung cho việc triển khai trên các nền tảng Cloud khác nhau.

Ứng dụng thực tế và ví dụ triển khai

Serverless Computing không chỉ là lý thuyết, mà đã được ứng dụng rộng rãi trong thực tế để giải quyết nhiều vấn đề nghiệp vụ. Dưới đây là các ứng dụng của Serverless phổ biến:

Xây dựng API Backend và Web Apps

Đây là ứng dụng cơ bản nhất. Thay vì dùng một server Node.js hoặc Python chạy liên tục để xử lý API, bạn sử dụng AWS Lambda hoặc Azure Functions để xử lý các HTTP Request thông qua API Gateway.

- Ví dụ Fast Byte: Một công ty E-commerce sử dụng kiến trúc Serverless để xử lý các đơn hàng. Khi người dùng nhấn nút “Thanh toán”, một hàm Serverless sẽ được kích hoạt để kiểm tra tồn kho, gửi email xác nhận và cập nhật trạng thái đơn hàng trong database.

Xử lý tập tin Media và Dữ liệu theo thời gian thực

Các tác vụ xử lý bất đồng bộ (Asynchronous) là môi trường lý tưởng cho Serverless Computing.

- Ví dụ: Khi người dùng tải một bức ảnh độ phân giải cao lên dịch vụ lưu trữ (ví dụ: S3), sự kiện “Upload” sẽ kích hoạt một hàm Serverless (FaaS). Hàm này có nhiệm vụ:

- Tự động thay đổi kích thước ảnh (resizing) để tạo ra các phiên bản thu nhỏ (thumbnails).

- Lưu trữ các phiên bản ảnh mới vào S3.

- Cập nhật URL ảnh mới vào cơ sở dữ liệu.

- Tất cả quá trình diễn ra chỉ trong vài giây và không tốn chi phí chờ.

Xây dựng Chatbot và Trợ lý ảo

Các nền tảng Chatbot như Dialogflow hoặc Bot Framework thường được tích hợp với Serverless Computing để xử lý logic đàm thoại. Khi người dùng nhập tin nhắn, hàm Serverless được kích hoạt để phân tích yêu cầu, tra cứu thông tin và trả lời.

Tác vụ Cron Job và Báo cáo theo lịch trình

Thay vì phải duy trì một máy chủ riêng chỉ để chạy các tác vụ định kỳ (Cron Job), bạn có thể sử dụng các hàm Serverless được kích hoạt theo lịch trình.

- Ví dụ: Một hàm Serverless chạy lúc 3 giờ sáng hàng ngày để tổng hợp dữ liệu bán hàng, gửi báo cáo qua email và dọn dẹp các bản ghi cũ trong database.

So sánh với các mô hình truyền thống

Để hiểu rõ hơn về giá trị của Serverless Computing, Fast Byte sẽ đặt nó cạnh các mô hình Cloud truyền thống và kiến trúc Microservices/Containers.

Serverless vs IaaS (Infrastructure as a Service – Máy chủ ảo/VM)

Để lựa chọn mô hình điện toán phù hợp, có thể đối chiếu đặc điểm giữa IaaS và Serverless Computing.

| Đặc điểm | IaaS (VM/EC2) | Serverless Computing (FaaS) |

|---|---|---|

| Quản lý máy chủ | Hoàn toàn do người dùng. Cần vá lỗi, quản lý hệ điều hành. | Hoàn toàn do Cloud Provider. Người dùng chỉ quản lý code. |

| Mở rộng | Cần cấu hình Auto-scaling Group thủ công, mất thời gian. | Tự động, gần như tức thì. |

| Chi phí | Trả tiền cho thời gian chạy (dù không tải). | Trả tiền theo mức sử dụng (chỉ khi có request). |

| Độ trễ khởi động | Thấp (máy chủ chạy liên tục). | Có thể có Cold Start (độ trễ cao hơn khi hàm không hoạt động). |

Serverless vs PaaS (Platform as a Service)

PaaS (ví dụ: AWS Elastic Beanstalk, Heroku) cung cấp môi trường chạy và tự động quản lý hệ điều hành, nhưng bạn vẫn cần cấu hình số lượng Instance (máy chủ) cần thiết.

- PaaS: Bạn cấu hình 5 máy chủ và trả tiền cho cả 5 máy, ngay cả khi chúng chạy không tải.

- Serverless Computing: Bạn không cần cấu hình số lượng, hệ thống tự động mở rộng từ 0 đến N và ngược lại. Khả năng Auto-scaling của Serverless linh hoạt và chi tiết hơn.

Serverless vs Containers (Docker/Kubernetes)

Đây là cuộc so sánh quan trọng nhất đối với Developer và DevOps Engineer.

- Containers (Kubernetes/Docker): Mang lại sự di động (Portability) cao và kiểm soát hoàn toàn môi trường chạy. Bạn đóng gói mọi thứ (code, thư viện, runtime) vào Container và quản lý cụm máy chủ (Cluster). Vẫn cần quản lý hạ tầng Cluster, dù ít hơn VM.

- Serverless Computing: Cung cấp tính năng Không quản lý máy chủ triệt để. Bạn mất quyền kiểm soát môi trường chạy, nhưng đổi lại là hiệu quả chi phí và tốc độ phát triển cực cao.

Kết luận của Fast Byte: Lựa chọn Serverless vs Container phụ thuộc vào yêu cầu:

- Chọn Containers nếu bạn cần kiểm soát Runtime, cần thực thi lâu hơn 15 phút, và cần sự di động cao.

- Chọn Serverless Computing nếu ưu tiên tối ưu chi phí Cloud và tốc độ phát triển, và ứng dụng của bạn là Event-driven.

Lưu ý khi lựa chọn và triển khai

Trước khi quyết định chuyển đổi kiến trúc sang Serverless Computing, bạn cần cân nhắc một số lưu ý khi triển khai Serverless sau để đảm bảo thành công:

Phân tích loại hình ứng dụng

Serverless Computing phù hợp với dự án nào?

- Phù hợp:

- Các ứng dụng có lưu lượng truy cập không thường xuyên hoặc theo đợt (ví dụ: trang Landing Page sự kiện, ứng dụng nội bộ ít dùng).

- Các tác vụ xử lý sự kiện (Event Processing).

- Các ứng dụng được xây dựng theo kiến trúc Microservices (các dịch vụ nhỏ, độc lập).

- Không phù hợp:

- Các ứng dụng cần duy trì kết nối liên tục (như Web Socket).

- Các tác vụ tính toán kéo dài hơn 15 phút.

- Các hệ thống yêu cầu kiểm soát tuyệt đối các yếu tố cấp thấp (low-level).

Chiến lược quản lý State

Trong Serverless Computing, các hàm không lưu trữ trạng thái (Stateless). Điều này có nghĩa là mọi dữ liệu tạm thời cần phải được lưu trữ bên ngoài (ví dụ: Database, Caching Layer như Redis).

- Lưu ý: Tuyệt đối không lưu trữ phiên (session) hoặc dữ liệu người dùng tạm thời bên trong hàm Serverless, vì Container có thể bị hủy bất cứ lúc nào. Sự tách biệt trạng thái này là chìa khóa để đạt được khả năng mở rộng tự động.

Kiểm soát chi phí và Billing

Mặc dù Serverless giúp tối ưu chi phí Cloud, nhưng nếu không được giám sát, chi phí có thể tăng vọt không kiểm soát khi lưu lượng truy cập tăng đột biến.

- Giải pháp: Cấu hình cảnh báo (Alert) trên Cloud Provider để nhận thông báo khi số lần gọi hàm vượt quá ngưỡng dự kiến. Điều này giúp bạn tránh khỏi những hóa đơn bất ngờ do lỗi logic hoặc tấn công.

Quản lý Dependencies và Layering

Khi phát triển Serverless Computing với các ngôn ngữ như Python hoặc Node.js, việc quản lý các thư viện bên ngoài (Dependencies) là rất quan trọng.

- Mẹo chuyên gia: Sử dụng Lambda Layers (đối với AWS Lambda) để tách biệt Code Logic và các thư viện bên ngoài. Điều này giúp giảm thiểu kích thước gói code và rút ngắn thời gian triển khai.

Tổng kết

Serverless Computing là một sự thay đổi mô hình triệt để trong cách chúng ta xây dựng và vận hành ứng dụng Cloud. Nó không chỉ là xu hướng mà còn là giải pháp thực tế giải quyết được các vấn đề cốt lõi về chi phí và quản lý hạ tầng cho nhiều loại hình doanh nghiệp.

Từ việc hiểu Serverless Computing là gì đến nắm rõ các thách thức và hạn chế của nó, Fast Byte hy vọng bạn đã có đủ kiến thức chuyên sâu để đưa ra quyết định sáng suốt cho dự án tiếp theo của mình.

Nếu bạn đang tìm kiếm một phương pháp để tối ưu chi phí Cloud Bill và tăng tốc độ triển khai ứng dụng, mô hình Serverless Computing chắc chắn là con đường bạn nên theo đuổi. Đừng để nỗi sợ Cold Start Serverless cản trở bạn, vì đã có nhiều giải pháp hiệu quả được triển khai. Hãy bắt đầu thử nghiệm với một hàm AWS Lambda đơn giản ngay hôm nay để tự mình trải nghiệm sức mạnh của điện toán phi máy chủ.